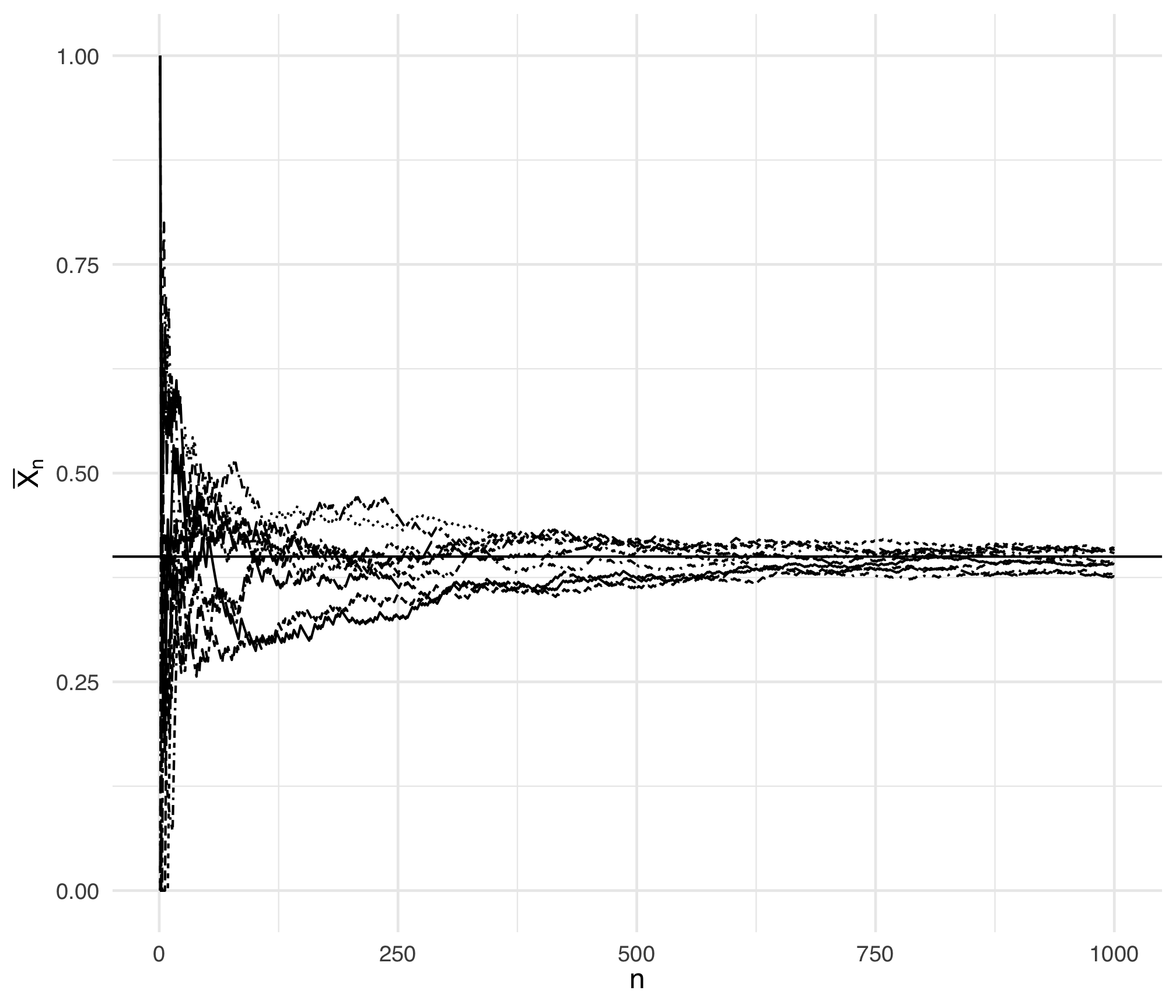

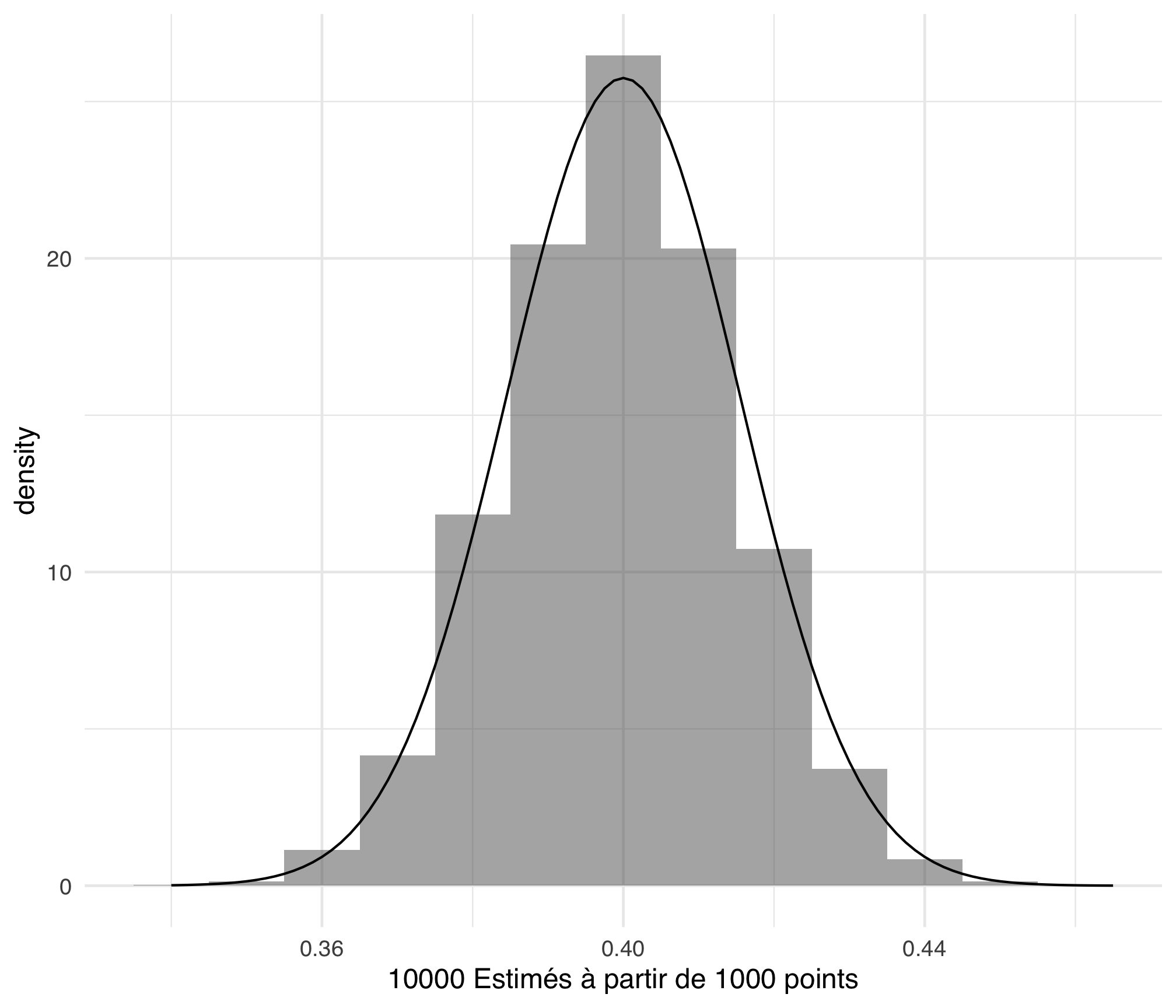

name: inter-slide class: left, middle, inverse {{ content }} --- name: layout-general layout: true class: left, middle <style> .remark-slide-number { position: inherit; } .remark-slide-number .progress-bar-container { position: absolute; bottom: 0; height: 4px; display: block; left: 0; right: 0; } .remark-slide-number .progress-bar { height: 100%; background-color: red; } </style> <div> <style type="text/css">.xaringan-extra-logo { width: 110px; height: 128px; z-index: 0; background-image: url(./img/Universite_Paris_logo_horizontal.jpg); background-size: contain; background-repeat: no-repeat; position: absolute; top:1em;right:1em; } </style> <script>(function () { let tries = 0 function addLogo () { if (typeof slideshow === 'undefined') { tries += 1 if (tries < 10) { setTimeout(addLogo, 100) } } else { document.querySelectorAll('.remark-slide-content:not(.hide_logo)') .forEach(function (slide) { const logo = document.createElement('a') logo.classList = 'xaringan-extra-logo' logo.href = 'http://master.math.univ-paris-diderot.fr/annee/m1-mi/' slide.appendChild(logo) }) } } document.addEventListener('DOMContentLoaded', addLogo) })()</script> </div> --- class: middle, left, inverse # Exploratory Data Analysis : Statistiques I ### 2022-01-15 #### [Master I MIDS & MFA]() #### [Statistique Fondamentale](http://stephane-v-boucheron.fr/courses/statistics-paris/) #### [Stéphane Boucheron](http://stephane-v-boucheron.fr) --- template: inter-slide ## <svg aria-hidden="true" role="img" viewBox="0 0 576 512" style="height:1em;width:1.12em;vertical-align:-0.125em;margin-left:auto;margin-right:auto;font-size:inherit;fill:white;overflow:visible;position:relative;"><path d="M0 117.66v346.32c0 11.32 11.43 19.06 21.94 14.86L160 416V32L20.12 87.95A32.006 32.006 0 0 0 0 117.66zM192 416l192 64V96L192 32v384zM554.06 33.16L416 96v384l139.88-55.95A31.996 31.996 0 0 0 576 394.34V48.02c0-11.32-11.43-19.06-21.94-14.86z"/></svg> ### Objectifs ### Un problème jouet ### Expérience, Statistique, Estimateur ### Expériences binomiales ### Propriétés des estimateurs ### Intervalles de confiance ### Tests --- template: inter-slide ## Objectifs --- ### Trois piliers de l'inférence statistique - Estimation ponctuelle -- - Région de confiance -- - Tests d'hypothèses ??? Ce premier cours introduit autour d'un exemple élémentaire les principaux thèmes de la statistique dite inférentielle (qu'on distingue de la statistique dite descriptive). Ces trois thèmes, l'estimation ponctuelle, la construction de régions de confiance et la construction de procédures de décision (les tests), suppose un effort préalable de modélisation stochastique. Sur l'exemple élémentaire, on peut mener ce travail de modélisation. Cela nous conduit à une première formulation de ce qu'est une expérience ou un modèle statistique. Dans le cadre le plus simple, une expérience statistique est une collection de lois de probabilités. On observe une ou des réalisations d'une de ces lois (sans savoir à laquelle on a affaire). On cherche à estimer, inférer des propriétés de cette loi, peut être pour prendre une décision. Nous passerons en revue des définitions qui nous seront utiles pendant toute la suite du cours (statistique, estimateur, biais, risque, ...) Et surtout nous verrons à cette occasion comment les théorèmes limites du calcul des probabilités, loi des grands nombres, théorème central limite, nous guident dans la construction et la justification des méthodes d'estimation et de décision. Nous verrons aussi que ces théorèmes limites sont complétés par des résultats non-asymptotiques appelés inégalités de concentration. Nous terminerons ce cours par une première version du résultat fondateur de la thérie des tests, le lemme de Neyman et Pearson. --- template: inter-slide ## Un problème jouet --- ### Coups de dés, lancers de pièces On va jouer à _pile ou face_ avec une pièce de monnaie <svg aria-hidden="true" role="img" viewBox="0 0 512 512" style="height:1em;width:1em;vertical-align:-0.125em;margin-left:auto;margin-right:auto;font-size:inherit;fill:currentColor;overflow:visible;position:relative;"><path d="M504 256c0 136.967-111.033 248-248 248S8 392.967 8 256 119.033 8 256 8s248 111.033 248 248zm-141.651-35.33c4.937-32.999-20.191-50.739-54.55-62.573l11.146-44.702-27.213-6.781-10.851 43.524c-7.154-1.783-14.502-3.464-21.803-5.13l10.929-43.81-27.198-6.781-11.153 44.686c-5.922-1.349-11.735-2.682-17.377-4.084l.031-.14-37.53-9.37-7.239 29.062s20.191 4.627 19.765 4.913c11.022 2.751 13.014 10.044 12.68 15.825l-12.696 50.925c.76.194 1.744.473 2.829.907-.907-.225-1.876-.473-2.876-.713l-17.796 71.338c-1.349 3.348-4.767 8.37-12.471 6.464.271.395-19.78-4.937-19.78-4.937l-13.51 31.147 35.414 8.827c6.588 1.651 13.045 3.379 19.4 5.006l-11.262 45.213 27.182 6.781 11.153-44.733a1038.209 1038.209 0 0 0 21.687 5.627l-11.115 44.523 27.213 6.781 11.262-45.128c46.404 8.781 81.299 5.239 95.986-36.727 11.836-33.79-.589-53.281-25.004-65.991 17.78-4.098 31.174-15.792 34.747-39.949zm-62.177 87.179c-8.41 33.79-65.308 15.523-83.755 10.943l14.944-59.899c18.446 4.603 77.6 13.717 68.811 48.956zm8.417-87.667c-7.673 30.736-55.031 15.12-70.393 11.292l13.548-54.327c15.363 3.828 64.836 10.973 56.845 43.035z"/></svg> <img src="./img/pexels-pixabay-210600.jpg" width="350px" align="right"> On soupçonne que cette pièce n'est pas parfaitement équilibrée: la probabilité d'obtenir _face_ ( `\(\theta\)` ) n'est pas exactement `\(1/2\)` Avant de jouer, on veut _estimer_ `\(\theta\)`, ou le ratio `\(\theta/(1- \theta)\)`, ou `\(\log \theta/(1- \theta)\)` Pour estimer cette probabilité, on réalise `\(n\)` lancers aléatoires indépendants On note les résultats: `$$\underbrace{x_1, x_2, \ldots, x_n}_{\text{les données, l'échantillon}}$$` --- ### Estimation ponctuelle On construit à partir des données `\(x_1, x_2, \ldots, x_n\)` une _estimation_ `\(\widehat{\theta}_n\)` de `\(\theta\)` `$$\underbrace{x_1, x_2, \ldots, x_n}_{\text{échantillon}} \stackrel{\text{estimation}}{⟶} \widehat{\theta}_n$$` <svg aria-hidden="true" role="img" viewBox="0 0 576 512" style="height:1em;width:1.12em;vertical-align:-0.125em;margin-left:auto;margin-right:auto;font-size:inherit;fill:currentColor;overflow:visible;position:relative;"><path d="M569.517 440.013C587.975 472.007 564.806 512 527.94 512H48.054c-36.937 0-59.999-40.055-41.577-71.987L246.423 23.985c18.467-32.009 64.72-31.951 83.154 0l239.94 416.028zM288 354c-25.405 0-46 20.595-46 46s20.595 46 46 46 46-20.595 46-46-20.595-46-46-46zm-43.673-165.346l7.418 136c.347 6.364 5.609 11.346 11.982 11.346h48.546c6.373 0 11.635-4.982 11.982-11.346l7.418-136c.375-6.874-5.098-12.654-11.982-12.654h-63.383c-6.884 0-12.356 5.78-11.981 12.654z"/></svg> Cette estimation est une _fonction des données_, pas de l'estimande `\(\theta\)` qui reste inconnue <img src="./img/pexels-pixabay-45848.jpg" width="300px" align="right" margin="5px"> On espère que `\(\widehat{\theta}_n\)` sera proche de `\(\theta\)` Nous avons affaire à un problème dit d'_estimation ponctuelle_ Le résultat d'une estimation ponctuelle est une valeur (un réel ici) --- ### Région de confiance Savoir que l'estimation ponctuelle est peut-etre (voire probablement) proche de l'estimande est satisfaisant mais d'un intérêt limité. Pour envisager l'avenir, il est plus utile de construire un _intervalle de confiance_:deux fonctions des données `\(\underline{\theta}_n, \overline{\theta}_n\)` telles que > avec une forte probabilité (à définir), l'estimande `\(\theta\)` appartient à l'intervalle aléatoire `$$\left[ \underline{\theta}_n(x_1, \ldots, x_n), \overline{\theta}_n (x_1, \ldots, x_n)\right] =: [\underline{\theta}_n, \overline{\theta}_n]$$` Ce problème est celui de la construction de _régions de confiance_. --- ### Région de confiance Il faut réaliser un bon _compromis_ entre - la _précision_ de l'intervalle de confiance `$$\overline{\theta}_n -\underline{\theta}_n$$` - la probabilité de _couverture_: la probabilité de l'événement `$$\Big\{ \omega : \theta \in \underbrace{[\underline{\theta}_n(\omega), \overline{\theta}_n(\omega)]}_{\text{dépend des données}}\Big\}$$` ??? ne pas encourager les approches ceintures et bretelles --- ### Décision <img src="./img/pexels-sora-shimazaki-5668882.jpg" width="300px" align="right" margin="5px"> On peut se poser un problème de _décision_ Par exemple : > on est prêt à jouer avec une pièce biaisée en faveur de _face_, mais pas avec une pièce biaisée en faveur de _pile_, Comment décider à partir des données si on est prêt à jouer ou non ? Comment décider entre - l'_hypothèse_ `\(\theta > 1/2\)` et - l'_hypothèse_ `\(\theta<1/2\)` ? C'est le problème des _tests_ --- template: inter-slide ## Quelques définitions --- ### Expérience statistique, échantillon, statistique, estimateur La notion d'_expérience statistique_ est une formalisation dans le langage du calcul des probabilités du jeu que nous venons d'évoquer. Au départ, on dispose d'un espace probabilisable `\((\Omega, \mathcal{F})\)` (l'univers et une tribu de parties). Ici `\(\Omega= \{ \text{pile}, \text{face}\}\)` et `\(\mathcal{F}= 2 ^ \Omega\)` -- C'est en général plus riche, avec `\(\Omega = \mathbb{R}^d\)` et `\(\mathcal{F}\)` les boréliens de `\(\mathbb{R}^d\)` On peut aussi rencontrer des situations où `\(\Omega\)` est un espace de fonctions (statistique des processus), le choix de la tribu n'est plus tout à fait évident. --- Sur cet espace probabilisable, on considère un _ensemble de lois de probabilités_ `\(\mathcal{P}\)`. Chaque loi de `\(\mathcal{P}\)` est susceptible de régir le phénomène que le statisticien cherche à étudier -- > Dans le cadre du problème jouet, on peut choisir `\(\mathcal{P}\)` comme l'ensemble de lois non-dégénérées sur `\(\Omega = \{ \text{pile}, \text{face}\}\)`. > Dans le problème jouet `\(\mathcal{P}\)` est l'ensemble des lois de Bernoulli > La probabilité d'obtenir _face_ est notée `\(\theta \in ]0,1[\)` Nos problèmes d'inférence (estimation ponctuelle, région de confiance, tests) portent sur ce `\(\theta\)` qui n'est pas connu de la statisticienne --- ### Paramétrisation On peut munir `\(\mathcal{P}\)` d'un _système de coordonnées_, d'une _paramétrisation_, c'est à dire d'une fonction d'un ensemble `\(\Theta\)` (souvent une partie de `\(\Theta \subseteq \mathbb{R}^d\)` ) dans `\(\mathcal{P}\)` <svg aria-hidden="true" role="img" viewBox="0 0 512 512" style="height:1em;width:1em;vertical-align:-0.125em;margin-left:auto;margin-right:auto;font-size:inherit;fill:currentColor;overflow:visible;position:relative;"><path d="M512 199.652c0 23.625-20.65 43.826-44.8 43.826h-99.851c16.34 17.048 18.346 49.766-6.299 70.944 14.288 22.829 2.147 53.017-16.45 62.315C353.574 425.878 322.654 448 272 448c-2.746 0-13.276-.203-16-.195-61.971.168-76.894-31.065-123.731-38.315C120.596 407.683 112 397.599 112 385.786V214.261l.002-.001c.011-18.366 10.607-35.889 28.464-43.845 28.886-12.994 95.413-49.038 107.534-77.323 7.797-18.194 21.384-29.084 40-29.092 34.222-.014 57.752 35.098 44.119 66.908-3.583 8.359-8.312 16.67-14.153 24.918H467.2c23.45 0 44.8 20.543 44.8 43.826zM96 200v192c0 13.255-10.745 24-24 24H24c-13.255 0-24-10.745-24-24V200c0-13.255 10.745-24 24-24h48c13.255 0 24 10.745 24 24zM68 368c0-11.046-8.954-20-20-20s-20 8.954-20 20 8.954 20 20 20 20-8.954 20-20z"/></svg> On note génériquement `\(P_ \theta\)` l'élément de `\(\mathcal{P}\)` associé à `\(\theta\)` > Dans le cas de notre problème jouet, nous avons implicitement paramétrisé les lois de Bernoulli par les probabilités de succès <svg aria-hidden="true" role="img" viewBox="0 0 192 512" style="height:1em;width:0.38em;vertical-align:-0.125em;margin-left:auto;margin-right:auto;font-size:inherit;fill:currentColor;overflow:visible;position:relative;"><path d="M176 432c0 44.112-35.888 80-80 80s-80-35.888-80-80 35.888-80 80-80 80 35.888 80 80zM25.26 25.199l13.6 272C39.499 309.972 50.041 320 62.83 320h66.34c12.789 0 23.331-10.028 23.97-22.801l13.6-272C167.425 11.49 156.496 0 142.77 0H49.23C35.504 0 24.575 11.49 25.26 25.199z"/></svg> Une paramétrisation est un choix de convenance --- ### Identifiabilité <svg aria-hidden="true" role="img" viewBox="0 0 512 512" style="height:1em;width:1em;vertical-align:-0.125em;margin-left:auto;margin-right:auto;font-size:inherit;fill:currentColor;overflow:visible;position:relative;"><path d="M256.12 245.96c-13.25 0-24 10.74-24 24 1.14 72.25-8.14 141.9-27.7 211.55-2.73 9.72 2.15 30.49 23.12 30.49 10.48 0 20.11-6.92 23.09-17.52 13.53-47.91 31.04-125.41 29.48-224.52.01-13.25-10.73-24-23.99-24zm-.86-81.73C194 164.16 151.25 211.3 152.1 265.32c.75 47.94-3.75 95.91-13.37 142.55-2.69 12.98 5.67 25.69 18.64 28.36 13.05 2.67 25.67-5.66 28.36-18.64 10.34-50.09 15.17-101.58 14.37-153.02-.41-25.95 19.92-52.49 54.45-52.34 31.31.47 57.15 25.34 57.62 55.47.77 48.05-2.81 96.33-10.61 143.55-2.17 13.06 6.69 25.42 19.76 27.58 19.97 3.33 26.81-15.1 27.58-19.77 8.28-50.03 12.06-101.21 11.27-152.11-.88-55.8-47.94-101.88-104.91-102.72zm-110.69-19.78c-10.3-8.34-25.37-6.8-33.76 3.48-25.62 31.5-39.39 71.28-38.75 112 .59 37.58-2.47 75.27-9.11 112.05-2.34 13.05 6.31 25.53 19.36 27.89 20.11 3.5 27.07-14.81 27.89-19.36 7.19-39.84 10.5-80.66 9.86-121.33-.47-29.88 9.2-57.88 28-80.97 8.35-10.28 6.79-25.39-3.49-33.76zm109.47-62.33c-15.41-.41-30.87 1.44-45.78 4.97-12.89 3.06-20.87 15.98-17.83 28.89 3.06 12.89 16 20.83 28.89 17.83 11.05-2.61 22.47-3.77 34-3.69 75.43 1.13 137.73 61.5 138.88 134.58.59 37.88-1.28 76.11-5.58 113.63-1.5 13.17 7.95 25.08 21.11 26.58 16.72 1.95 25.51-11.88 26.58-21.11a929.06 929.06 0 0 0 5.89-119.85c-1.56-98.75-85.07-180.33-186.16-181.83zm252.07 121.45c-2.86-12.92-15.51-21.2-28.61-18.27-12.94 2.86-21.12 15.66-18.26 28.61 4.71 21.41 4.91 37.41 4.7 61.6-.11 13.27 10.55 24.09 23.8 24.2h.2c13.17 0 23.89-10.61 24-23.8.18-22.18.4-44.11-5.83-72.34zm-40.12-90.72C417.29 43.46 337.6 1.29 252.81.02 183.02-.82 118.47 24.91 70.46 72.94 24.09 119.37-.9 181.04.14 246.65l-.12 21.47c-.39 13.25 10.03 24.31 23.28 24.69.23.02.48.02.72.02 12.92 0 23.59-10.3 23.97-23.3l.16-23.64c-.83-52.5 19.16-101.86 56.28-139 38.76-38.8 91.34-59.67 147.68-58.86 69.45 1.03 134.73 35.56 174.62 92.39 7.61 10.86 22.56 13.45 33.42 5.86 10.84-7.62 13.46-22.59 5.84-33.43z"/></svg> .bg-light-gray.b--light-gray.ba.bw1.br3.shadow-5.ph4.mt5[ Une paramétrisation est dite _identifiable_ si `$$\theta \neq \theta' \Rightarrow P_ \theta \neq P_{\theta'}$$` ] > Dans notre problème jouet, les paramétrisations (par la probabilité de _face_, par le ratio des probabilités _face_/_pile_, ou son logarithme) sont identifiables -- <svg aria-hidden="true" role="img" viewBox="0 0 576 512" style="height:1em;width:1.12em;vertical-align:-0.125em;margin-left:auto;margin-right:auto;font-size:inherit;fill:currentColor;overflow:visible;position:relative;"><path d="M569.517 440.013C587.975 472.007 564.806 512 527.94 512H48.054c-36.937 0-59.999-40.055-41.577-71.987L246.423 23.985c18.467-32.009 64.72-31.951 83.154 0l239.94 416.028zM288 354c-25.405 0-46 20.595-46 46s20.595 46 46 46 46-20.595 46-46-20.595-46-46-46zm-43.673-165.346l7.418 136c.347 6.364 5.609 11.346 11.982 11.346h48.546c6.373 0 11.635-4.982 11.982-11.346l7.418-136c.375-6.874-5.098-12.654-11.982-12.654h-63.383c-6.884 0-12.356 5.78-11.981 12.654z"/></svg> L'identifiabilité est une propriété désirable mais ce n'est pas indispensable : les modèles de _mélange_, les _modèles à variables latentes_ sont très utiles mais rarement identifiables --- ### Observations partielles <img src="./img/pexels-lorenzo-241544.jpg" align="right" width="400px" style="vertical-align:middle;margin:0px 50px"> Il est possible que le statisticien n'ait pas directement accès complet aux réalisations des tirages selon `\(P\)` (la loi de la nature), c'est à dire aux éléments de `\(\Omega\)` -- <svg aria-hidden="true" role="img" viewBox="0 0 640 512" style="height:1em;width:1.25em;vertical-align:-0.125em;margin-left:auto;margin-right:auto;font-size:inherit;fill:currentColor;overflow:visible;position:relative;"><path d="M476 480H324a36 36 0 0 1-36-36V96h-96v156a36 36 0 0 1-36 36H16a16 16 0 0 1-16-16v-32a16 16 0 0 1 16-16h112V68a36 36 0 0 1 36-36h152a36 36 0 0 1 36 36v348h96V260a36 36 0 0 1 36-36h140a16 16 0 0 1 16 16v32a16 16 0 0 1-16 16H512v156a36 36 0 0 1-36 36z"/></svg> Par exemple, lorsque `\(\Omega\)` est un espace de fonctions (les trajectoires d'un processus), il est sans doute trop couteux d'observer l'infinité de points qui forment la trajectoire On se contente d'observer la trajectoire périodiquement (ou pas), on _échantillonne_ --- ### Espace d'observations <svg aria-hidden="true" role="img" viewBox="0 0 640 512" style="height:1em;width:1.25em;vertical-align:-0.125em;margin-left:auto;margin-right:auto;font-size:inherit;fill:currentColor;overflow:visible;position:relative;"><path d="M208 352c-2.39 0-4.78.35-7.06 1.09C187.98 357.3 174.35 360 160 360c-14.35 0-27.98-2.7-40.95-6.91-2.28-.74-4.66-1.09-7.05-1.09C49.94 352-.33 402.48 0 464.62.14 490.88 21.73 512 48 512h224c26.27 0 47.86-21.12 48-47.38.33-62.14-49.94-112.62-112-112.62zm-48-32c53.02 0 96-42.98 96-96s-42.98-96-96-96-96 42.98-96 96 42.98 96 96 96zM592 0H208c-26.47 0-48 22.25-48 49.59V96c23.42 0 45.1 6.78 64 17.8V64h352v288h-64v-64H384v64h-76.24c19.1 16.69 33.12 38.73 39.69 64H592c26.47 0 48-22.25 48-49.59V49.59C640 22.25 618.47 0 592 0z"/></svg> Pour formaliser ces situations, on ajoute à l'expérience un _espace d'observations_ `\(\mathcal{X}\)` (muni d'une tribu `\(\mathcal{G}\)`) et une fonction `$$X: \Omega \longrightarrow \mathcal{X}$$` qu'on suppose `\(\mathcal{G}/\mathcal{F}\)` mesurable. -- Toute loi `\(P \in \mathcal{P}\)` définit alors une loi image `\(P \circ X^{-1}\)` Au lieu d'observer `\(\omega\in \Omega\)`, on observe `\(x = X(\omega) \in \mathcal{X}\)` Une expérience statistique générale est donc définie par `$$(\Omega, \mathcal{F}, \mathcal{P}, \Theta, \mathcal{X}, \mathcal{G}, X)$$` -- Dans les situations dites _canoniques_, `$$\Omega=\mathcal{X}\qquad \text{et} \qquad X =\text{Id}$$` --- ### Expériences "produit" `\(\otimes\)` Nous nous concentrons sur les expériences dites _produit_, construites à partir de répétitions _indépendantes_ d'une expérience de base Ces expériences sont de la forme `$$(\Omega^n, \sigma\left(\times_{i=1}^n \mathcal{F}\right), \mathcal{P}_n:= \{ P^{\otimes n}, P \in \mathcal{P} \}, \Theta, \mathcal{X}^n, \sigma\left( \times_{i=1}^n \mathcal{G}\right), X)$$` On dit que `\(x_i\)` est la réalisation de `\(X_i\)` (variable aléatoire). -- La loi jointe de `\(X_1, \ldots, X_n\)` est une loi produit de la forme `$$(P_ \theta \circ X^{-1})^{\otimes n}\qquad \text{avec } \theta \in \Theta$$` `$$\forall B_1, \ldots, B_n \in \mathcal{G}, \qquad P_ \theta^{\otimes n}\left( \cup_{i=1}^n \{ X_i \in B_i \}\right) = \prod_{i=1}^n P_ \theta \{X_i \in B_i\}$$` -- On parle d'_expérience échantillonnée_ --- <img src="./img/pexels-pixabay-210600.jpg" width="300px" align="right"> <svg aria-hidden="true" role="img" viewBox="0 0 576 512" style="height:1em;width:1.12em;vertical-align:-0.125em;margin-left:auto;margin-right:auto;font-size:inherit;fill:currentColor;overflow:visible;position:relative;"><path d="M569.517 440.013C587.975 472.007 564.806 512 527.94 512H48.054c-36.937 0-59.999-40.055-41.577-71.987L246.423 23.985c18.467-32.009 64.72-31.951 83.154 0l239.94 416.028zM288 354c-25.405 0-46 20.595-46 46s20.595 46 46 46 46-20.595 46-46-20.595-46-46-46zm-43.673-165.346l7.418 136c.347 6.364 5.609 11.346 11.982 11.346h48.546c6.373 0 11.635-4.982 11.982-11.346l7.418-136c.375-6.874-5.098-12.654-11.982-12.654h-63.383c-6.884 0-12.356 5.78-11.981 12.654z"/></svg> Souvent, on se contente de rappeler `\((P_ \theta, \theta \in \Theta)\)` Le reste est sous-entendu <svg aria-hidden="true" role="img" viewBox="0 0 496 512" style="height:1em;width:0.97em;vertical-align:-0.125em;margin-left:auto;margin-right:auto;font-size:inherit;fill:currentColor;overflow:visible;position:relative;"><path d="M0 256c0 137 111 248 248 248s248-111 248-248S385 8 248 8 0 119 0 256zm200-48c0 17.7-14.3 32-32 32s-32-14.3-32-32 14.3-32 32-32 32 14.3 32 32zm158.5 16.5c-14.8-13.2-46.2-13.2-61 0L288 233c-8.3 7.4-21.6.4-19.8-10.8 4-25.2 34.2-42.1 59.9-42.1S384 197 388 222.2c1.7 11.1-11.4 18.3-19.8 10.8l-9.7-8.5zM157.8 325.8C180.2 352.7 213 368 248 368s67.8-15.4 90.2-42.2c13.6-16.2 38.1 4.2 24.6 20.5C334.3 380.4 292.5 400 248 400s-86.3-19.6-114.8-53.8c-13.5-16.3 11.2-36.7 24.6-20.4z"/></svg> > Dans notre problème jouet, cela donne `\((B_ \theta, \theta \in ]0,1[)\)` où `\(B_ \theta\)` est la loi de Bernoulli de probabilité de succès `\(\theta\)` --- ### Statistique .bg-light-gray.b--light-gray.ba.bw1.br3.shadow-5.ph4.mt5[ Toute fonction mesurable sur l'espace des observations `\(\mathcal{X}^n\)` définit ce qu'on nomme une _statistique_ ] Exemples .bg-light-gray.b--light-gray.ba.bw1.br3.shadow-5.ph4.mt5[ - La _moyenne empirique_ `\(\overline{X}_n:= \frac{1}{n} \sum_{i=1}^n x_i\)` ] .bg-light-gray.b--light-gray.ba.bw1.br3.shadow-5.ph4.mt5[ - La _variance empirique_ `\(S^2:= \frac{1}{n} \sum_{i=1}^n \left(x_i - \overline{X}_n \right)^2\)` ] ??? Dans le langage des statistiques descriptives, la moyenne empirique décrit la localisation de l'échantillon, la variance empirique décrit la dispersion. --- ### Estimateur .bg-light-gray.b--light-gray.ba.bw1.br3.shadow-5.ph4.mt5[ <svg aria-hidden="true" role="img" viewBox="0 0 496 512" style="height:1em;width:0.97em;vertical-align:-0.125em;margin-left:auto;margin-right:auto;font-size:inherit;fill:currentColor;overflow:visible;position:relative;"><path d="M248 8C111 8 0 119 0 256s111 248 248 248 248-111 248-248S385 8 248 8zm80 168c17.7 0 32 14.3 32 32s-14.3 32-32 32-32-14.3-32-32 14.3-32 32-32zm-160 0c17.7 0 32 14.3 32 32s-14.3 32-32 32-32-14.3-32-32 14.3-32 32-32zm170.2 218.2C315.8 367.4 282.9 352 248 352s-67.8 15.4-90.2 42.2c-13.5 16.3-38.1-4.2-24.6-20.5C161.7 339.6 203.6 320 248 320s86.3 19.6 114.7 53.8c13.6 16.2-11 36.7-24.5 20.4z"/></svg> Un _estimateur_ n'est qu'une statistique censée estimer une caractéristique (inconnue) de la loi inconnue qui sous-tend l'échantillonage ] Par exemple, dans notre problème jouet, on peut chercher à estimer `$$P_ \theta\{ \text{Face}\}= \theta$$` par `\(\overline{X}_n\)` en utilisant la convention `$$X(\text{Face})=1= 1-X(\text{Pile})$$` -- <svg aria-hidden="true" role="img" viewBox="0 0 576 512" style="height:1em;width:1.12em;vertical-align:-0.125em;margin-left:auto;margin-right:auto;font-size:inherit;fill:currentColor;overflow:visible;position:relative;"><path d="M569.517 440.013C587.975 472.007 564.806 512 527.94 512H48.054c-36.937 0-59.999-40.055-41.577-71.987L246.423 23.985c18.467-32.009 64.72-31.951 83.154 0l239.94 416.028zM288 354c-25.405 0-46 20.595-46 46s20.595 46 46 46 46-20.595 46-46-20.595-46-46-46zm-43.673-165.346l7.418 136c.347 6.364 5.609 11.346 11.982 11.346h48.546c6.373 0 11.635-4.982 11.982-11.346l7.418-136c.375-6.874-5.098-12.654-11.982-12.654h-63.383c-6.884 0-12.356 5.78-11.981 12.654z"/></svg> un estimateur est une _fonction de l'échantillon_, et non pas une fonction de la _loi de l'échantillonnage_. -- <svg aria-hidden="true" role="img" viewBox="0 0 576 512" style="height:1em;width:1.12em;vertical-align:-0.125em;margin-left:auto;margin-right:auto;font-size:inherit;fill:currentColor;overflow:visible;position:relative;"><path d="M569.517 440.013C587.975 472.007 564.806 512 527.94 512H48.054c-36.937 0-59.999-40.055-41.577-71.987L246.423 23.985c18.467-32.009 64.72-31.951 83.154 0l239.94 416.028zM288 354c-25.405 0-46 20.595-46 46s20.595 46 46 46 46-20.595 46-46-20.595-46-46-46zm-43.673-165.346l7.418 136c.347 6.364 5.609 11.346 11.982 11.346h48.546c6.373 0 11.635-4.982 11.982-11.346l7.418-136c.375-6.874-5.098-12.654-11.982-12.654h-63.383c-6.884 0-12.356 5.78-11.981 12.654z"/></svg> La loi de l'estimateur dépend (en général) de la loi de l'échantillonnage. -- <svg aria-hidden="true" role="img" viewBox="0 0 512 512" style="height:1em;width:1em;vertical-align:-0.125em;margin-left:auto;margin-right:auto;font-size:inherit;fill:currentColor;overflow:visible;position:relative;"><path d="M512 199.652c0 23.625-20.65 43.826-44.8 43.826h-99.851c16.34 17.048 18.346 49.766-6.299 70.944 14.288 22.829 2.147 53.017-16.45 62.315C353.574 425.878 322.654 448 272 448c-2.746 0-13.276-.203-16-.195-61.971.168-76.894-31.065-123.731-38.315C120.596 407.683 112 397.599 112 385.786V214.261l.002-.001c.011-18.366 10.607-35.889 28.464-43.845 28.886-12.994 95.413-49.038 107.534-77.323 7.797-18.194 21.384-29.084 40-29.092 34.222-.014 57.752 35.098 44.119 66.908-3.583 8.359-8.312 16.67-14.153 24.918H467.2c23.45 0 44.8 20.543 44.8 43.826zM96 200v192c0 13.255-10.745 24-24 24H24c-13.255 0-24-10.745-24-24V200c0-13.255 10.745-24 24-24h48c13.255 0 24 10.745 24 24zM68 368c0-11.046-8.954-20-20-20s-20 8.954-20 20 8.954 20 20 20 20-8.954 20-20z"/></svg> Quand le paramètre à estimer s'appelle `\(\theta, \psi, \ldots\)`, on utilise souvent le raccourci `\(\widehat{\theta}\)` ou `\(\widehat{\theta}_n, \widehat{\psi}_n , \ldots\)` pour désigner l'estimateur, plutôt que `\(\widehat{\theta}(X_1, \ldots, X_n)\)` ou `\(\widehat{\psi}(X_1, \ldots, X_n)\)` --- ### Echantillons de Bernoulli <svg aria-hidden="true" role="img" viewBox="0 0 581 512" style="height:1em;width:1.13em;vertical-align:-0.125em;margin-left:auto;margin-right:auto;font-size:inherit;fill:currentColor;overflow:visible;position:relative;"><path d="M581 226.6C581 119.1 450.9 32 290.5 32S0 119.1 0 226.6C0 322.4 103.3 402 239.4 418.1V480h99.1v-61.5c24.3-2.7 47.6-7.4 69.4-13.9L448 480h112l-67.4-113.7c54.5-35.4 88.4-84.9 88.4-139.7zm-466.8 14.5c0-73.5 98.9-133 220.8-133s211.9 40.7 211.9 133c0 50.1-26.5 85-70.3 106.4-2.4-1.6-4.7-2.9-6.4-3.7-10.2-5.2-27.8-10.5-27.8-10.5s86.6-6.4 86.6-92.7-90.6-87.9-90.6-87.9h-199V361c-74.1-21.5-125.2-67.1-125.2-119.9zm225.1 38.3v-55.6c57.8 0 87.8-6.8 87.8 27.3 0 36.5-38.2 28.3-87.8 28.3zm-.9 72.5H365c10.8 0 18.9 11.7 24 19.2-16.1 1.9-33 2.8-50.6 2.9v-22.1z"/></svg> Pour engendrer une suite de `\(N=\)` 100 variables de Bernoulli indépendantes de probabilité de succès `\(p=\)` 0.4, on utilise le générateur de nombres aléatoires `rbinom`, ```r N <- 100 # taille échantillon p <- .4 # θ! *s <- rbinom(n=N, prob=p, size=1) mean(s) ``` ``` ## [1] 0.43 ``` Le premier argument nommé - `n` désigne le nombre de tirages - `prob` la probabilité de succès des lois de Bernoulli, - `size` désigne le paramètre de taille des binomiales on effectue `N` tirages binomiaux de paramètres `size=1` et `prob` --- L'API des générateurs aléatoires de lois univariées en <svg aria-hidden="true" role="img" viewBox="0 0 581 512" style="height:1em;width:1.13em;vertical-align:-0.125em;margin-left:auto;margin-right:auto;font-size:inherit;fill:currentColor;overflow:visible;position:relative;"><path d="M581 226.6C581 119.1 450.9 32 290.5 32S0 119.1 0 226.6C0 322.4 103.3 402 239.4 418.1V480h99.1v-61.5c24.3-2.7 47.6-7.4 69.4-13.9L448 480h112l-67.4-113.7c54.5-35.4 88.4-84.9 88.4-139.7zm-466.8 14.5c0-73.5 98.9-133 220.8-133s211.9 40.7 211.9 133c0 50.1-26.5 85-70.3 106.4-2.4-1.6-4.7-2.9-6.4-3.7-10.2-5.2-27.8-10.5-27.8-10.5s86.6-6.4 86.6-92.7-90.6-87.9-90.6-87.9h-199V361c-74.1-21.5-125.2-67.1-125.2-119.9zm225.1 38.3v-55.6c57.8 0 87.8-6.8 87.8 27.3 0 36.5-38.2 28.3-87.8 28.3zm-.9 72.5H365c10.8 0 18.9 11.7 24 19.2-16.1 1.9-33 2.8-50.6 2.9v-22.1z"/></svg> et de la forme ```r rdistrib(n, param1, param2, param3) ``` avec - `distrib` : nom de la ditribution (`binom`, `unif`, `pois`, `norm`, `exp`, ...) - `n` : nombre de tirages à réaliser - `param1`, `param2`, `param3`, ... paramètre de la distribution --- La statistique dite inférentielle (l'objet de ce cours) est construite à partir des résultats fondamentaux du calcul des probabilités : - lois des grands nombres - théorème central limite - théorèmes de convergence en distribution plus généraux - autres : principes de grandes déviations, concentration --- > Dans le cadre du problème jouet, la loi des grands nombres nous indique qu'il est > très raisonnable d'estimer la probabilité de succès _inconnue_ `\(\theta\)` > en utilisant la fréquence des succès <svg aria-hidden="true" role="img" viewBox="0 0 640 512" style="height:1em;width:1.25em;vertical-align:-0.125em;margin-left:auto;margin-right:auto;font-size:inherit;fill:currentColor;overflow:visible;position:relative;"><path d="M639.4 433.6c-8.4-20.4-31.8-30.1-52.2-21.6l-22.1 9.2-38.7-101.9c47.9-35 64.8-100.3 34.5-152.8L474.3 16c-8-13.9-25.1-19.7-40-13.6L320 49.8 205.7 2.4c-14.9-6.2-32-.3-40 13.6L79.1 166.5C48.9 219 65.7 284.3 113.6 319.2L74.9 421.1l-22.1-9.2c-20.4-8.5-43.7 1.2-52.2 21.6-1.7 4.1.2 8.8 4.3 10.5l162.3 67.4c4.1 1.7 8.7-.2 10.4-4.3 8.4-20.4-1.2-43.8-21.6-52.3l-22.1-9.2L173.3 342c4.4.5 8.8 1.3 13.1 1.3 51.7 0 99.4-33.1 113.4-85.3l20.2-75.4 20.2 75.4c14 52.2 61.7 85.3 113.4 85.3 4.3 0 8.7-.8 13.1-1.3L506 445.6l-22.1 9.2c-20.4 8.5-30.1 31.9-21.6 52.3 1.7 4.1 6.4 6 10.4 4.3L635.1 444c4-1.7 6-6.3 4.3-10.4zM275.9 162.1l-112.1-46.5 36.5-63.4 94.5 39.2-18.9 70.7zm88.2 0l-18.9-70.7 94.5-39.2 36.5 63.4-112.1 46.5z"/></svg> --- ### Loi(s) des grands nombres <svg aria-hidden="true" role="img" viewBox="0 0 512 512" style="height:1em;width:1em;vertical-align:-0.125em;margin-left:auto;margin-right:auto;font-size:inherit;fill:currentColor;overflow:visible;position:relative;"><path d="M201.5 174.8l55.7 55.8c3.1 3.1 3.1 8.2 0 11.3l-11.3 11.3c-3.1 3.1-8.2 3.1-11.3 0l-55.7-55.8-45.3 45.3 55.8 55.8c3.1 3.1 3.1 8.2 0 11.3l-11.3 11.3c-3.1 3.1-8.2 3.1-11.3 0L111 265.2l-26.4 26.4c-17.3 17.3-25.6 41.1-23 65.4l7.1 63.6L2.3 487c-3.1 3.1-3.1 8.2 0 11.3l11.3 11.3c3.1 3.1 8.2 3.1 11.3 0l66.3-66.3 63.6 7.1c23.9 2.6 47.9-5.4 65.4-23l181.9-181.9-135.7-135.7-64.9 65zm308.2-93.3L430.5 2.3c-3.1-3.1-8.2-3.1-11.3 0l-11.3 11.3c-3.1 3.1-3.1 8.2 0 11.3l28.3 28.3-45.3 45.3-56.6-56.6-17-17c-3.1-3.1-8.2-3.1-11.3 0l-33.9 33.9c-3.1 3.1-3.1 8.2 0 11.3l17 17L424.8 223l17 17c3.1 3.1 8.2 3.1 11.3 0l33.9-34c3.1-3.1 3.1-8.2 0-11.3l-73.5-73.5 45.3-45.3 28.3 28.3c3.1 3.1 8.2 3.1 11.3 0l11.3-11.3c3.1-3.2 3.1-8.2 0-11.4z"/></svg> .bg-light-gray.b--light-gray.ba.bw1.br3.shadow-5.ph4.mt5[ - `\(X_1, \ldots, X_n, \ldots \sim_{\text{i.i.d.}} P\)` - `\(\mu = \mathbb{E}_P X_i\)` (on sous-entend `\(\mathbb{E}_P |X_i| <\infty\)`) - `\(\mathbb{P}\)`: loi produit sur `\(\mathbb{R}^{\mathbb{N}}\)` `$$\mathbb{P} (B_1 \times B_2 \times \ldots \times B_n) = \prod_{i=1}^n P(B_i) \qquad \forall B_i \in \mathcal{B}(\mathbb{R})$$` `$$\forall \epsilon >0, \qquad \mathbb{P} \Bigg\{ \left| \frac{1}{n}\sum_{i=1}^n X_i - \mu\right| > \epsilon \Bigg\} \rightarrow 0 \qquad \text{loi faible}$$` `$$\mathbb{P} \Bigg\{ \lim_n \underbrace{\frac{1}{n}\sum_{i=1}^n X_i}_{\text{moyenne empirique}} = \mu \Bigg\} = 1 \qquad \text{loi forte}$$` ] --- Avec <svg aria-hidden="true" role="img" viewBox="0 0 581 512" style="height:1em;width:1.13em;vertical-align:-0.125em;margin-left:auto;margin-right:auto;font-size:inherit;fill:currentColor;overflow:visible;position:relative;"><path d="M581 226.6C581 119.1 450.9 32 290.5 32S0 119.1 0 226.6C0 322.4 103.3 402 239.4 418.1V480h99.1v-61.5c24.3-2.7 47.6-7.4 69.4-13.9L448 480h112l-67.4-113.7c54.5-35.4 88.4-84.9 88.4-139.7zm-466.8 14.5c0-73.5 98.9-133 220.8-133s211.9 40.7 211.9 133c0 50.1-26.5 85-70.3 106.4-2.4-1.6-4.7-2.9-6.4-3.7-10.2-5.2-27.8-10.5-27.8-10.5s86.6-6.4 86.6-92.7-90.6-87.9-90.6-87.9h-199V361c-74.1-21.5-125.2-67.1-125.2-119.9zm225.1 38.3v-55.6c57.8 0 87.8-6.8 87.8 27.3 0 36.5-38.2 28.3-87.8 28.3zm-.9 72.5H365c10.8 0 18.9 11.7 24 19.2-16.1 1.9-33 2.8-50.6 2.9v-22.1z"/></svg>, nous allons simuler des lancers de pièces (des tirages de Bernoulli) et étudier/visualiser les trajectoires des moyennes empiriques `$$\left(\frac{1}{n} \sum_{i=1}^n X_i \right)_{n \leq N} = \left( \overline{X}_n\right)_{n \leq N}$$` La _loi des grands nombres_ peut être illustrée dans ce contexte -- - On construit d'abord `\(B\)` trajectoires des sommes partielles `\(\sum_{i=1}^n X_i\)` pour `\(i=1, \ldots, N\)` : chaque trajectoire forme une colonne d'un `dataframe`, - On ajoute une colonne `x` représentant les indices `\(n=1, \ldots, N\)`. - On fait _pivoter_ le `dataframe` pour obtenir un `dataframe` à trois colonnes: `x`, `path` qui précise la trajectoire, et `value` qui donne la somme partielle `\(\sum_{i=1}^n X_i\)` pour la trajectoire désignée par `path` à l'instant `n` désigné par `x` - On confie ce `dataframe` pivoté au module de visualisation `ggplot2` --- count: false ### LGN: Trajectoires des moyennes empiriques ```r *rbinom(n=B*N, prob=p, size=1) %>% * matrix(nrow=N, ncol=B) %>% * apply(MARGIN=2, FUN=cumsum) ``` --- count: false ### LGN: Trajectoires des moyennes empiriques ```r rbinom(n=B*N, prob=p, size=1) %>% matrix(nrow=N, ncol=B) %>% apply(MARGIN=2, FUN=cumsum) %>% * as_tibble(.rows = N) %>% * mutate(x = 1:N) %>% * pivot_longer(cols = starts_with('V'), * names_to = "path") ``` --- count: false ### LGN: Trajectoires des moyennes empiriques ```r rbinom(n=B*N, prob=p, size=1) %>% matrix(nrow=N, ncol=B) %>% apply(MARGIN=2, FUN=cumsum) %>% as_tibble(.rows = N) %>% mutate(x = 1:N) %>% pivot_longer(cols = starts_with('V'), names_to = "path") %>% * ggplot(aes(x=x, * y=value/x, * linetype=path)) + * geom_line(show.legend = FALSE) ``` --- count: false ### LGN: Trajectoires des moyennes empiriques ```r rbinom(n=B*N, prob=p, size=1) %>% matrix(nrow=N, ncol=B) %>% apply(MARGIN=2, FUN=cumsum) %>% as_tibble(.rows = N) %>% mutate(x = 1:N) %>% pivot_longer(cols = starts_with('V'), names_to = "path") %>% ggplot(aes(x=x, y=value/x, linetype=path)) + geom_line(show.legend = FALSE) + * geom_abline(slope=0, * intercept = p) ``` --- count: false ### LGN: Trajectoires des moyennes empiriques ```r rbinom(n=B*N, prob=p, size=1) %>% matrix(nrow=N, ncol=B) %>% apply(MARGIN=2, FUN=cumsum) %>% as_tibble(.rows = N) %>% mutate(x = 1:N) %>% pivot_longer(cols = starts_with('V'), names_to = "path") %>% ggplot(aes(x=x, y=value/x, linetype=path)) + geom_line(show.legend = FALSE) + geom_abline(slope=0, intercept = p) + * xlab(TeX('$n$')) + * ylab(TeX("$\\bar{X}_n$")) + * theme() ``` <style> .panel1-LGN-viz-user { color: black; width: 99%; hight: 32%; float: left; padding-left: 1%; font-size: 80% } .panel2-LGN-viz-user { color: black; width: NA%; hight: 32%; float: left; padding-left: 1%; font-size: 80% } .panel3-LGN-viz-user { color: black; width: NA%; hight: 33%; float: left; padding-left: 1%; font-size: 80% } </style> On visualise `\(B=\)` 10 trajectoires construites chacune sur `\(N=\)` 1000 épreuves de Bernoulli --- ### LGN: Trajectoires des moyennes empiriques .fl.w-third.pa2[ On visualise `\(B=\)` 10 trajectoires des moyennes empiriques construites chacune sur `\(N=\)` 1000 épreuves de Bernoulli Les moyennes empiriques `$$\overline{X}_n(\omega) = \frac{1}{n}\sum_{i=1}^n X_i(\omega)$$` convergent (presque sûrement) vers l'espérance des Bernoulli qui vaut ici `\(p=\)` 0.4 ] .fl.w-two-thirds.pa2[  ] --- ### Visualisation à temps fixe Nous pouvons aussi fixer le nombre d'observations `\(n = N\)` et examiner les fluctuations de la moyenne empirique `\(\overline{X}_n\)` sur un grand nombre `\(B = 10000\)` de trajectoires Nous nous rappelons que si `\(X_i \sim_{text{i.i.d.}} \text{Bernoulli}(θ)\)` alors `\(\sum_{i=1}^N X_i \sim \text{Binomiale}(N, θ)\)`. Pour simuler nos `\(B\)` moyennes empiriques, il suffit d'invoquer `rbinom(B, p, N)` Pour visualiser les fluctuations des moyennes empiriques, nous utilisons la technique de l'_histogramme_ L'histogramme est construit grace à [`ggplot`](https://ggplot2.tidyverse.org) --- count: false ### Histogramme des estimés d'un paramètre de Bernoulli ```r *B <- 10000 # Réplications *N <- 1000 # Taille échantillon *p <- .4 ``` --- count: false ### Histogramme des estimés d'un paramètre de Bernoulli ```r B <- 10000 # Réplications N <- 1000 # Taille échantillon p <- .4 *estimes <- * rbinom(B, p, size=N)/N ``` --- count: false ### Histogramme des estimés d'un paramètre de Bernoulli ```r B <- 10000 # Réplications N <- 1000 # Taille échantillon p <- .4 estimes <- rbinom(B, p, size=N)/N *tibble(x=estimes) %>% * ggplot(aes(x=x)) ``` --- count: false ### Histogramme des estimés d'un paramètre de Bernoulli ```r B <- 10000 # Réplications N <- 1000 # Taille échantillon p <- .4 estimes <- rbinom(B, p, size=N)/N tibble(x=estimes) %>% ggplot(aes(x=x)) + * geom_histogram(aes(y=..density..), * binwidth=.01, * alpha=I(.5)) ``` --- count: false ### Histogramme des estimés d'un paramètre de Bernoulli ```r B <- 10000 # Réplications N <- 1000 # Taille échantillon p <- .4 estimes <- rbinom(B, p, size=N)/N tibble(x=estimes) %>% ggplot(aes(x=x)) + geom_histogram(aes(y=..density..), binwidth=.01, alpha=I(.5)) + * stat_function(fun=dnorm, * args=c(mean=p, * sd=sqrt(p*(1-p)/N))) ``` --- count: false ### Histogramme des estimés d'un paramètre de Bernoulli ```r B <- 10000 # Réplications N <- 1000 # Taille échantillon p <- .4 estimes <- rbinom(B, p, size=N)/N tibble(x=estimes) %>% ggplot(aes(x=x)) + geom_histogram(aes(y=..density..), binwidth=.01, alpha=I(.5)) + stat_function(fun=dnorm, args=c(mean=p, sd=sqrt(p*(1-p)/N))) + * xlab(paste(B, " Estimés à partir de ", * N," points", * sep="")) ``` <style> .panel1-hist_estim_binom-user { color: black; width: 99%; hight: 32%; float: left; padding-left: 1%; font-size: 80% } .panel2-hist_estim_binom-user { color: black; width: NA%; hight: 32%; float: left; padding-left: 1%; font-size: 80% } .panel3-hist_estim_binom-user { color: black; width: NA%; hight: 33%; float: left; padding-left: 1%; font-size: 80% } </style> --- ### Histogramme des estimés d'un paramètre de Bernoulli .fl.w-third.pa2[ Un estimateur est une variable aléatoire. On peut visualiser ses fluctuations à l'aide de maintes techniques graphiques comme les histogrammes L'histogramme définit une densité de probabilité constante par morceaux Nous comparons cette densité constante par morceaux avec la densité de `\(\mathcal{N}(\theta, θ(1-θ)/N)\)` ] .fl.w-two-thirds.pa2[  ] --- ```r summary(estimes) ``` ``` ## Min. 1st Qu. Median Mean 3rd Qu. Max. ## 0.340 0.390 0.400 0.400 0.410 0.465 ``` ```r var(estimes) ``` ``` ## [1] 0.0002349826 ``` ```r sd(estimes) ``` ``` ## [1] 0.01532914 ``` ```r IQR(estimes) ``` ``` ## [1] 0.02 ``` --- class: center, middle, inverse ## Propriétés des estimateurs --- ### Paramètres <svg aria-hidden="true" role="img" viewBox="0 0 496 512" style="height:1em;width:0.97em;vertical-align:-0.125em;margin-left:auto;margin-right:auto;font-size:inherit;fill:currentColor;overflow:visible;position:relative;"><path d="M248 8C111 8 0 119 0 256s111 248 248 248 248-111 248-248S385 8 248 8zM136 208c0-17.7 14.3-32 32-32s32 14.3 32 32-14.3 32-32 32-32-14.3-32-32zm112 208c-35.3 0-64-28.7-64-64s28.7-64 64-64 64 28.7 64 64-28.7 64-64 64zm80-176c-17.7 0-32-14.3-32-32s14.3-32 32-32 32 14.3 32 32-14.3 32-32 32z"/></svg> La plupart des expériences/modèles statistiques que nous rencontrerons dans ce cours, seront de nature _paramétrique_, autrement dit indexés par des parties de `\(\mathbb{R}^d\)` <svg aria-hidden="true" role="img" viewBox="0 0 512 512" style="height:1em;width:1em;vertical-align:-0.125em;margin-left:auto;margin-right:auto;font-size:inherit;fill:currentColor;overflow:visible;position:relative;"><path d="M512 199.652c0 23.625-20.65 43.826-44.8 43.826h-99.851c16.34 17.048 18.346 49.766-6.299 70.944 14.288 22.829 2.147 53.017-16.45 62.315C353.574 425.878 322.654 448 272 448c-2.746 0-13.276-.203-16-.195-61.971.168-76.894-31.065-123.731-38.315C120.596 407.683 112 397.599 112 385.786V214.261l.002-.001c.011-18.366 10.607-35.889 28.464-43.845 28.886-12.994 95.413-49.038 107.534-77.323 7.797-18.194 21.384-29.084 40-29.092 34.222-.014 57.752 35.098 44.119 66.908-3.583 8.359-8.312 16.67-14.153 24.918H467.2c23.45 0 44.8 20.543 44.8 43.826zM96 200v192c0 13.255-10.745 24-24 24H24c-13.255 0-24-10.745-24-24V200c0-13.255 10.745-24 24-24h48c13.255 0 24 10.745 24 24zM68 368c0-11.046-8.954-20-20-20s-20 8.954-20 20 8.954 20 20 20 20-8.954 20-20z"/></svg> Dans de nombreux développements des statistiques, par exemple en _estimation de densité_, on travaille sur des modèles plus riches qui n'admettent pas de paramétrisation _naturelle_ par une partie d'un espace euclidien de dimension finie <svg aria-hidden="true" role="img" viewBox="0 0 576 512" style="height:1em;width:1.12em;vertical-align:-0.125em;margin-left:auto;margin-right:auto;font-size:inherit;fill:currentColor;overflow:visible;position:relative;"><path d="M569.517 440.013C587.975 472.007 564.806 512 527.94 512H48.054c-36.937 0-59.999-40.055-41.577-71.987L246.423 23.985c18.467-32.009 64.72-31.951 83.154 0l239.94 416.028zM288 354c-25.405 0-46 20.595-46 46s20.595 46 46 46 46-20.595 46-46-20.595-46-46-46zm-43.673-165.346l7.418 136c.347 6.364 5.609 11.346 11.982 11.346h48.546c6.373 0 11.635-4.982 11.982-11.346l7.418-136c.375-6.874-5.098-12.654-11.982-12.654h-63.383c-6.884 0-12.356 5.78-11.981 12.654z"/></svg> On parle pourtant de paramètre d'une distribution pour désigner ce qui devrait plutôt s'appeler une _fonctionnelle_ Par exemple, - l'_espérance_, - la _covariance_ d'une distribution sur `\(\mathbb{R}^d\)` sont des paramètres de cette distribution Les _quantiles_, l'_asymétrie_, la _kurtosis_ sont d'autres paramètres --- ### Definition: biais .bg-light-gray.b--light-gray.ba.bw1.br3.shadow-5.ph4.mt5[ Soit `\(\psi(P)\)` un paramètre à estimer, et `\(\widehat{\psi}\)` un estimateur, on appelle _biais_ (ou biais moyen) sous la loi `\(P\)` de l'estimateur `\(\hat{\psi}\)`, la quantité `$$\mathbb{E}_{P}\left[ \widehat{\psi}- \psi(P)\right]$$` C'est l'écart entre la valeur moyenne de `\(\widehat{\psi}\)` et la valeur visée `\(\psi(P)\)` ] L'estimateur est dit _sans biais_ s'il est de biais nul --- ### Exemple d'estimateur sans biais Si on se place dans le modèle binomial et qu'on cherche à estimer la probabilité de succès `\(\theta\)`, la fréquence empirique des succès est un estimateur sans biais de `\(\theta\)` On peut vérifier qu'il n'existe pas d'estimateur sans biais de `\(1/\theta\)` ou de `\(\theta/(1- \theta)\)` <svg aria-hidden="true" role="img" viewBox="0 0 496 512" style="height:1em;width:0.97em;vertical-align:-0.125em;margin-left:auto;margin-right:auto;font-size:inherit;fill:currentColor;overflow:visible;position:relative;"><path d="M248 8C111 8 0 119 0 256s111 248 248 248 248-111 248-248S385 8 248 8zm80 168c17.7 0 32 14.3 32 32s-14.3 32-32 32-32-14.3-32-32 14.3-32 32-32zm-160 0c17.7 0 32 14.3 32 32s-14.3 32-32 32-32-14.3-32-32 14.3-32 32-32zm170.2 218.2C315.8 367.4 282.9 352 248 352s-67.8 15.4-90.2 42.2c-13.5 16.3-38.1-4.2-24.6-20.5C161.7 339.6 203.6 320 248 320s86.3 19.6 114.7 53.8c13.6 16.2-11 36.7-24.5 20.4z"/></svg> <svg aria-hidden="true" role="img" viewBox="0 0 640 512" style="height:1em;width:1.25em;vertical-align:-0.125em;margin-left:auto;margin-right:auto;font-size:inherit;fill:currentColor;overflow:visible;position:relative;"><path d="M639.4 433.6c-8.4-20.4-31.8-30.1-52.2-21.6l-22.1 9.2-38.7-101.9c47.9-35 64.8-100.3 34.5-152.8L474.3 16c-8-13.9-25.1-19.7-40-13.6L320 49.8 205.7 2.4c-14.9-6.2-32-.3-40 13.6L79.1 166.5C48.9 219 65.7 284.3 113.6 319.2L74.9 421.1l-22.1-9.2c-20.4-8.5-43.7 1.2-52.2 21.6-1.7 4.1.2 8.8 4.3 10.5l162.3 67.4c4.1 1.7 8.7-.2 10.4-4.3 8.4-20.4-1.2-43.8-21.6-52.3l-22.1-9.2L173.3 342c4.4.5 8.8 1.3 13.1 1.3 51.7 0 99.4-33.1 113.4-85.3l20.2-75.4 20.2 75.4c14 52.2 61.7 85.3 113.4 85.3 4.3 0 8.7-.8 13.1-1.3L506 445.6l-22.1 9.2c-20.4 8.5-30.1 31.9-21.6 52.3 1.7 4.1 6.4 6 10.4 4.3L635.1 444c4-1.7 6-6.3 4.3-10.4zM275.9 162.1l-112.1-46.5 36.5-63.4 94.5 39.2-18.9 70.7zm88.2 0l-18.9-70.7 94.5-39.2 36.5 63.4-112.1 46.5z"/></svg> La fréquence empirique d'un événement est toujours un estimateur sans biais de la probabilité de cet événement --- ### Exemple d'estimateur biaisé Si `\(\psi(P)\)` désigne la variance de la loi `\(P\)` sur `\(\mathbb{R}\)`, la variance empirique `$$S^2 = \frac{1}{n} \sum_{i=1}^n \big( X_i - \overline{X}_n\big)^2$$` est un estimateur biaisé de `\(\psi(P)\)`: `$$\mathbb{E}_P\left[ S^2 \right] = \frac{n-1}{n} \mathbb{E}_P \left[\left(X - \mathbb{E}_P X\right)^2\right] = \frac{n-1}{n} \psi(P)$$` <svg aria-hidden="true" role="img" viewBox="0 0 576 512" style="height:1em;width:1.12em;vertical-align:-0.125em;margin-left:auto;margin-right:auto;font-size:inherit;fill:currentColor;overflow:visible;position:relative;"><path d="M208 0c-29.9 0-54.7 20.5-61.8 48.2-.8 0-1.4-.2-2.2-.2-35.3 0-64 28.7-64 64 0 4.8.6 9.5 1.7 14C52.5 138 32 166.6 32 200c0 12.6 3.2 24.3 8.3 34.9C16.3 248.7 0 274.3 0 304c0 33.3 20.4 61.9 49.4 73.9-.9 4.6-1.4 9.3-1.4 14.1 0 39.8 32.2 72 72 72 4.1 0 8.1-.5 12-1.2 9.6 28.5 36.2 49.2 68 49.2 39.8 0 72-32.2 72-72V64c0-35.3-28.7-64-64-64zm368 304c0-29.7-16.3-55.3-40.3-69.1 5.2-10.6 8.3-22.3 8.3-34.9 0-33.4-20.5-62-49.7-74 1-4.5 1.7-9.2 1.7-14 0-35.3-28.7-64-64-64-.8 0-1.5.2-2.2.2C422.7 20.5 397.9 0 368 0c-35.3 0-64 28.6-64 64v376c0 39.8 32.2 72 72 72 31.8 0 58.4-20.7 68-49.2 3.9.7 7.9 1.2 12 1.2 39.8 0 72-32.2 72-72 0-4.8-.5-9.5-1.4-14.1 29-12 49.4-40.6 49.4-73.9z"/></svg> vérifier --- ### Definition : risque quadratique .bg-light-gray.b--light-gray.ba.bw1.br3.shadow-5.ph4.mt5[ Soit `\(\psi(P)\)` une paramètre à estimer, et `\(\widehat{\psi}\)` un estimateur, on appelle _écart quadratique moyen_ sous la loi `\(P\)` de l'estimateur `\(\widehat{\psi}\)` la quantité `$$\mathbb{E}_{P}\left[ \left(\widehat{\psi}- \psi(P)\right)^2\right]$$` ] --- ### Exemple Dans le cas du problème jouet, le risque quadratique de l'estimateur `\(\widehat{\theta}_n = \overline{X}_n\)` de `\(\theta\)` n'est autre que la variance de l'estimateur `$$\mathbb{E}_{\theta} \left[\left(\overline{X}_n - \theta\right)^2\right] = \frac{\theta(1- \theta )}{n}$$` <svg aria-hidden="true" role="img" viewBox="0 0 576 512" style="height:1em;width:1.12em;vertical-align:-0.125em;margin-left:auto;margin-right:auto;font-size:inherit;fill:currentColor;overflow:visible;position:relative;"><path d="M208 0c-29.9 0-54.7 20.5-61.8 48.2-.8 0-1.4-.2-2.2-.2-35.3 0-64 28.7-64 64 0 4.8.6 9.5 1.7 14C52.5 138 32 166.6 32 200c0 12.6 3.2 24.3 8.3 34.9C16.3 248.7 0 274.3 0 304c0 33.3 20.4 61.9 49.4 73.9-.9 4.6-1.4 9.3-1.4 14.1 0 39.8 32.2 72 72 72 4.1 0 8.1-.5 12-1.2 9.6 28.5 36.2 49.2 68 49.2 39.8 0 72-32.2 72-72V64c0-35.3-28.7-64-64-64zm368 304c0-29.7-16.3-55.3-40.3-69.1 5.2-10.6 8.3-22.3 8.3-34.9 0-33.4-20.5-62-49.7-74 1-4.5 1.7-9.2 1.7-14 0-35.3-28.7-64-64-64-.8 0-1.5.2-2.2.2C422.7 20.5 397.9 0 368 0c-35.3 0-64 28.6-64 64v376c0 39.8 32.2 72 72 72 31.8 0 58.4-20.7 68-49.2 3.9.7 7.9 1.2 12 1.2 39.8 0 72-32.2 72-72 0-4.8-.5-9.5-1.4-14.1 29-12 49.4-40.6 49.4-73.9z"/></svg> vérifier --- ### Décomposition biais-variance du risque quadratique .bg-light-gray.b--light-gray.ba.bw1.br3.shadow-5.ph4.mt5[ `$$\mathbb{E}_{P} \left[(\hat{\psi}-\psi)^2\right] = \underbrace{\operatorname{Var}_{P} [\hat{\psi}]}_{\text{variance}} + \underbrace{\left(\mathbb{E}_{P}[\hat{\psi}]-\psi \right)^2}_{\text{carré du biais}}$$` ] <svg aria-hidden="true" role="img" viewBox="0 0 576 512" style="height:1em;width:1.12em;vertical-align:-0.125em;margin-left:auto;margin-right:auto;font-size:inherit;fill:currentColor;overflow:visible;position:relative;"><path d="M208 0c-29.9 0-54.7 20.5-61.8 48.2-.8 0-1.4-.2-2.2-.2-35.3 0-64 28.7-64 64 0 4.8.6 9.5 1.7 14C52.5 138 32 166.6 32 200c0 12.6 3.2 24.3 8.3 34.9C16.3 248.7 0 274.3 0 304c0 33.3 20.4 61.9 49.4 73.9-.9 4.6-1.4 9.3-1.4 14.1 0 39.8 32.2 72 72 72 4.1 0 8.1-.5 12-1.2 9.6 28.5 36.2 49.2 68 49.2 39.8 0 72-32.2 72-72V64c0-35.3-28.7-64-64-64zm368 304c0-29.7-16.3-55.3-40.3-69.1 5.2-10.6 8.3-22.3 8.3-34.9 0-33.4-20.5-62-49.7-74 1-4.5 1.7-9.2 1.7-14 0-35.3-28.7-64-64-64-.8 0-1.5.2-2.2.2C422.7 20.5 397.9 0 368 0c-35.3 0-64 28.6-64 64v376c0 39.8 32.2 72 72 72 31.8 0 58.4-20.7 68-49.2 3.9.7 7.9 1.2 12 1.2 39.8 0 72-32.2 72-72 0-4.8-.5-9.5-1.4-14.1 29-12 49.4-40.6 49.4-73.9z"/></svg> vérifier C'est une relation pythagoricienne ! <img src="./img/Scuola_di_atene_16_pitagora.jpg" align="right" width="300px"> La relation du risque quadratique à la taille de l'échantillon est une question importante en statistique mathématique Elle concerne la _vitesse d'estimation_ : pour une suite d'expériences donnée, quelles sont les meilleures vitesses envisageables, et comment les obtenir ? --- Pour introduire la notion de _consistance d'une suite d'estimateurs_, nous aurons besoin des notions de convergence en probabilité et de convergence presque sûre ### Definition <svg aria-hidden="true" role="img" viewBox="0 0 512 512" style="height:1em;width:1em;vertical-align:-0.125em;margin-left:auto;margin-right:auto;font-size:inherit;fill:currentColor;overflow:visible;position:relative;"><path d="M201.5 174.8l55.7 55.8c3.1 3.1 3.1 8.2 0 11.3l-11.3 11.3c-3.1 3.1-8.2 3.1-11.3 0l-55.7-55.8-45.3 45.3 55.8 55.8c3.1 3.1 3.1 8.2 0 11.3l-11.3 11.3c-3.1 3.1-8.2 3.1-11.3 0L111 265.2l-26.4 26.4c-17.3 17.3-25.6 41.1-23 65.4l7.1 63.6L2.3 487c-3.1 3.1-3.1 8.2 0 11.3l11.3 11.3c3.1 3.1 8.2 3.1 11.3 0l66.3-66.3 63.6 7.1c23.9 2.6 47.9-5.4 65.4-23l181.9-181.9-135.7-135.7-64.9 65zm308.2-93.3L430.5 2.3c-3.1-3.1-8.2-3.1-11.3 0l-11.3 11.3c-3.1 3.1-3.1 8.2 0 11.3l28.3 28.3-45.3 45.3-56.6-56.6-17-17c-3.1-3.1-8.2-3.1-11.3 0l-33.9 33.9c-3.1 3.1-3.1 8.2 0 11.3l17 17L424.8 223l17 17c3.1 3.1 8.2 3.1 11.3 0l33.9-34c3.1-3.1 3.1-8.2 0-11.3l-73.5-73.5 45.3-45.3 28.3 28.3c3.1 3.1 8.2 3.1 11.3 0l11.3-11.3c3.1-3.2 3.1-8.2 0-11.4z"/></svg> .bg-light-gray.b--light-gray.ba.bw1.br3.shadow-5.ph4.mt5[ Une suite `\((X_n)_n\)` de variables aléatoires à valeurs dans `\(\mathbb{R}^k\)`, vivant sur un espace probabilisé `\((\Omega,\mathcal{F},\mathbb{P})\)` _converge en probabilité_ vers une variable aléatoire `\(X\)` à valeurs dans `\(\mathbb{R}^k\)`, vivant sur cet espace probabilisé si et seulement si, `$$\forall \epsilon>0, \qquad \lim_n \mathbb{P} \{ \Vert X_n -X\Vert > \epsilon \} = 0$$` ] --- ### Definition: consistance .bg-light-gray.b--light-gray.ba.bw1.br3.shadow-5.ph4.mt5[ Dans une suite d'expériences statistiques échantillonnées, une suite d'estimateurs `\((\widehat{\theta}_n)_n\)` est - _consistante_ (pour l'estimation de `\(\theta\)`) si `$$\forall \theta \in \Theta, \forall \epsilon>0, \qquad \lim_n P^{\otimes n}_ \theta \left\{ \| \widehat{\theta}_n-\theta\| > \epsilon \right\} =0 \qquad\text{(convergence en probabilité).}$$` - _fortement consistante_ si `$$\forall \theta \in \Theta, \forall \epsilon>0, \qquad P^{\otimes \mathbb{N}}_ \theta \left\{ \lim_n \| \widehat{\theta}_n-\theta\| =0 \right\} =1 \qquad\text{(convergence presque sûre).}$$` ] --- Pour notre problème jouet, la suite d'estimateurs `\((\overline{X}_n)_n\)` est fortement consistante pour l'estimation de `\(\theta\)` (loi forte des grands nombres) <svg aria-hidden="true" role="img" viewBox="0 0 640 512" style="height:1em;width:1.25em;vertical-align:-0.125em;margin-left:auto;margin-right:auto;font-size:inherit;fill:currentColor;overflow:visible;position:relative;"><path d="M639.4 433.6c-8.4-20.4-31.8-30.1-52.2-21.6l-22.1 9.2-38.7-101.9c47.9-35 64.8-100.3 34.5-152.8L474.3 16c-8-13.9-25.1-19.7-40-13.6L320 49.8 205.7 2.4c-14.9-6.2-32-.3-40 13.6L79.1 166.5C48.9 219 65.7 284.3 113.6 319.2L74.9 421.1l-22.1-9.2c-20.4-8.5-43.7 1.2-52.2 21.6-1.7 4.1.2 8.8 4.3 10.5l162.3 67.4c4.1 1.7 8.7-.2 10.4-4.3 8.4-20.4-1.2-43.8-21.6-52.3l-22.1-9.2L173.3 342c4.4.5 8.8 1.3 13.1 1.3 51.7 0 99.4-33.1 113.4-85.3l20.2-75.4 20.2 75.4c14 52.2 61.7 85.3 113.4 85.3 4.3 0 8.7-.8 13.1-1.3L506 445.6l-22.1 9.2c-20.4 8.5-30.1 31.9-21.6 52.3 1.7 4.1 6.4 6 10.4 4.3L635.1 444c4-1.7 6-6.3 4.3-10.4zM275.9 162.1l-112.1-46.5 36.5-63.4 94.5 39.2-18.9 70.7zm88.2 0l-18.9-70.7 94.5-39.2 36.5 63.4-112.1 46.5z"/></svg> On peut aussi vérifier que la suite `\((\overline{X}_n/(1-\overline{X}_n))_n\)` est fortement consistante pour l'estimation de `\(\theta/(1- \theta)\)`. <svg aria-hidden="true" role="img" viewBox="0 0 576 512" style="height:1em;width:1.12em;vertical-align:-0.125em;margin-left:auto;margin-right:auto;font-size:inherit;fill:currentColor;overflow:visible;position:relative;"><path d="M208 0c-29.9 0-54.7 20.5-61.8 48.2-.8 0-1.4-.2-2.2-.2-35.3 0-64 28.7-64 64 0 4.8.6 9.5 1.7 14C52.5 138 32 166.6 32 200c0 12.6 3.2 24.3 8.3 34.9C16.3 248.7 0 274.3 0 304c0 33.3 20.4 61.9 49.4 73.9-.9 4.6-1.4 9.3-1.4 14.1 0 39.8 32.2 72 72 72 4.1 0 8.1-.5 12-1.2 9.6 28.5 36.2 49.2 68 49.2 39.8 0 72-32.2 72-72V64c0-35.3-28.7-64-64-64zm368 304c0-29.7-16.3-55.3-40.3-69.1 5.2-10.6 8.3-22.3 8.3-34.9 0-33.4-20.5-62-49.7-74 1-4.5 1.7-9.2 1.7-14 0-35.3-28.7-64-64-64-.8 0-1.5.2-2.2.2C422.7 20.5 397.9 0 368 0c-35.3 0-64 28.6-64 64v376c0 39.8 32.2 72 72 72 31.8 0 58.4-20.7 68-49.2 3.9.7 7.9 1.2 12 1.2 39.8 0 72-32.2 72-72 0-4.8-.5-9.5-1.4-14.1 29-12 49.4-40.6 49.4-73.9z"/></svg> --- ### Statistique suffisante <img src="./img/ob_a0a496_voyages-route-panneaux-direction-insid.jpg" align="right" width="300px"> Ces suites d'estimateurs répondent aux questions d'estimation ponctuelle On peut toutefois se demander s'il s'agit des meilleures réponses possibles. On peut par exemple se demander s'il n'y a pas d'information inexploitée dans l'échantillon --- ### Statistique suffisante On peut se rassurer en remarquant que pour tout `\(\theta\)` `$$\begin{array}{rcl} P_ \theta\{ x_1, \ldots, x_n \} &= & \theta^{n \overline{X}_n} (1- \theta)^{n(1-\overline{X}_n)} \\ & = & \left(\frac{\theta}{1- \theta}\right)^{n \overline{X}_n} (1- \theta)^n \\ & = & \exp\left( n \overline{X}_n \log\left(\frac{\theta}{1- \theta }\right) - n \log (1- \theta)\right)\end{array}$$` donc `$$P_ \theta\{ x_1, \ldots, x_n \mid \overline{X}_n\} = \frac{\mathbb{I}_{n \overline{X}_n = \sum_{i=1}^n x_i}}{\binom{n}{n \overline{X}_n}}$$` Conditionnellement à `\(\overline{X}_n\)`, la probabilité de l'échantillon ne dépend pas de `\(\theta\)`, est _libre_ de `\(\theta\)` Dans ce modèle jouet, `\(\overline{X}_n\)` est une _statistique suffisante_ ou _exhaustive_ <svg aria-hidden="true" role="img" viewBox="0 0 640 512" style="height:1em;width:1.25em;vertical-align:-0.125em;margin-left:auto;margin-right:auto;font-size:inherit;fill:currentColor;overflow:visible;position:relative;"><path d="M639.4 433.6c-8.4-20.4-31.8-30.1-52.2-21.6l-22.1 9.2-38.7-101.9c47.9-35 64.8-100.3 34.5-152.8L474.3 16c-8-13.9-25.1-19.7-40-13.6L320 49.8 205.7 2.4c-14.9-6.2-32-.3-40 13.6L79.1 166.5C48.9 219 65.7 284.3 113.6 319.2L74.9 421.1l-22.1-9.2c-20.4-8.5-43.7 1.2-52.2 21.6-1.7 4.1.2 8.8 4.3 10.5l162.3 67.4c4.1 1.7 8.7-.2 10.4-4.3 8.4-20.4-1.2-43.8-21.6-52.3l-22.1-9.2L173.3 342c4.4.5 8.8 1.3 13.1 1.3 51.7 0 99.4-33.1 113.4-85.3l20.2-75.4 20.2 75.4c14 52.2 61.7 85.3 113.4 85.3 4.3 0 8.7-.8 13.1-1.3L506 445.6l-22.1 9.2c-20.4 8.5-30.1 31.9-21.6 52.3 1.7 4.1 6.4 6 10.4 4.3L635.1 444c4-1.7 6-6.3 4.3-10.4zM275.9 162.1l-112.1-46.5 36.5-63.4 94.5 39.2-18.9 70.7zm88.2 0l-18.9-70.7 94.5-39.2 36.5 63.4-112.1 46.5z"/></svg> --- template: inter-slide ## Intervalles de confiance --- ### Definition: intervalle de niveau de confiance `\(1-\alpha\)` <img src="./img/pexels-dids-2379020.jpg" width="300px" align="right"> Lorsque l'espace des paramètres `\(\Theta\)` est inclus dans `\(\mathbb{R}\)`, un _intervalle de niveau de confiance `\(1- \alpha\)` avec `\(\alpha \in ]0,1[\)`_, est un couple de statistiques `\(\underline{\theta}_n, \overline{\theta}_n\)` telles que `$$\forall \theta \in \Theta, \qquad P_\theta^{\otimes n} \left\{ \theta \in [\underline{\theta}_n, \overline{\theta}_n]\right\} \geq 1- \alpha$$` --- <svg aria-hidden="true" role="img" viewBox="0 0 512 512" style="height:1em;width:1em;vertical-align:-0.125em;margin-left:auto;margin-right:auto;font-size:inherit;fill:currentColor;overflow:visible;position:relative;"><path d="M512 199.652c0 23.625-20.65 43.826-44.8 43.826h-99.851c16.34 17.048 18.346 49.766-6.299 70.944 14.288 22.829 2.147 53.017-16.45 62.315C353.574 425.878 322.654 448 272 448c-2.746 0-13.276-.203-16-.195-61.971.168-76.894-31.065-123.731-38.315C120.596 407.683 112 397.599 112 385.786V214.261l.002-.001c.011-18.366 10.607-35.889 28.464-43.845 28.886-12.994 95.413-49.038 107.534-77.323 7.797-18.194 21.384-29.084 40-29.092 34.222-.014 57.752 35.098 44.119 66.908-3.583 8.359-8.312 16.67-14.153 24.918H467.2c23.45 0 44.8 20.543 44.8 43.826zM96 200v192c0 13.255-10.745 24-24 24H24c-13.255 0-24-10.745-24-24V200c0-13.255 10.745-24 24-24h48c13.255 0 24 10.745 24 24zM68 368c0-11.046-8.954-20-20-20s-20 8.954-20 20 8.954 20 20 20 20-8.954 20-20z"/></svg> L'intervalle de confiance est une statistique <svg aria-hidden="true" role="img" viewBox="0 0 576 512" style="height:1em;width:1.12em;vertical-align:-0.125em;margin-left:auto;margin-right:auto;font-size:inherit;fill:currentColor;overflow:visible;position:relative;"><path d="M569.517 440.013C587.975 472.007 564.806 512 527.94 512H48.054c-36.937 0-59.999-40.055-41.577-71.987L246.423 23.985c18.467-32.009 64.72-31.951 83.154 0l239.94 416.028zM288 354c-25.405 0-46 20.595-46 46s20.595 46 46 46 46-20.595 46-46-20.595-46-46-46zm-43.673-165.346l7.418 136c.347 6.364 5.609 11.346 11.982 11.346h48.546c6.373 0 11.635-4.982 11.982-11.346l7.418-136c.375-6.874-5.098-12.654-11.982-12.654h-63.383c-6.884 0-12.356 5.78-11.981 12.654z"/></svg> L'intervalle de confiance doit être calculable à partir des données accessibles au statisticien y compris l'échantillon, y compris sa taille, `\(\alpha\)`, le cadre de l'expérience statistique Il n'est pas toujours évident de construire un intervalle de niveau de confiance exactement `\(1- \alpha\)` <svg aria-hidden="true" role="img" viewBox="0 0 496 512" style="height:1em;width:0.97em;vertical-align:-0.125em;margin-left:auto;margin-right:auto;font-size:inherit;fill:currentColor;overflow:visible;position:relative;"><path d="M248 8C111 8 0 119 0 256s111 248 248 248 248-111 248-248S385 8 248 8zm80 168c17.7 0 32 14.3 32 32s-14.3 32-32 32-32-14.3-32-32 14.3-32 32-32zm-160 0c17.7 0 32 14.3 32 32s-14.3 32-32 32-32-14.3-32-32 14.3-32 32-32zm170.2 218.2C315.8 367.4 282.9 352 248 352s-67.8 15.4-90.2 42.2c-13.5 16.3-38.1-4.2-24.6-20.5C161.7 339.6 203.6 320 248 320s86.3 19.6 114.7 53.8c13.6 16.2-11 36.7-24.5 20.4z"/></svg> On est très souvent amené à proposer des solutions très conservatrices: des intervalles trop larges <svg aria-hidden="true" role="img" viewBox="0 0 496 512" style="height:1em;width:0.97em;vertical-align:-0.125em;margin-left:auto;margin-right:auto;font-size:inherit;fill:currentColor;overflow:visible;position:relative;"><path d="M248 8C111 8 0 119 0 256s111 248 248 248 248-111 248-248S385 8 248 8zm80 168c17.7 0 32 14.3 32 32s-14.3 32-32 32-32-14.3-32-32 14.3-32 32-32zm-160 0c17.7 0 32 14.3 32 32s-14.3 32-32 32-32-14.3-32-32 14.3-32 32-32zm194.8 170.2C334.3 380.4 292.5 400 248 400s-86.3-19.6-114.8-53.8c-13.6-16.3 11-36.7 24.6-20.5 22.4 26.9 55.2 42.2 90.2 42.2s67.8-15.4 90.2-42.2c13.4-16.2 38.1 4.2 24.6 20.5z"/></svg> Le calcul des probabilités nous fournit des constructions assez simples d'intervalles de niveau de confiance asymptotique prescrit --- ### Construction naïve <svg aria-hidden="true" role="img" viewBox="0 0 512 512" style="height:1em;width:1em;vertical-align:-0.125em;margin-left:auto;margin-right:auto;font-size:inherit;fill:currentColor;overflow:visible;position:relative;"><path d="M201.5 174.8l55.7 55.8c3.1 3.1 3.1 8.2 0 11.3l-11.3 11.3c-3.1 3.1-8.2 3.1-11.3 0l-55.7-55.8-45.3 45.3 55.8 55.8c3.1 3.1 3.1 8.2 0 11.3l-11.3 11.3c-3.1 3.1-8.2 3.1-11.3 0L111 265.2l-26.4 26.4c-17.3 17.3-25.6 41.1-23 65.4l7.1 63.6L2.3 487c-3.1 3.1-3.1 8.2 0 11.3l11.3 11.3c3.1 3.1 8.2 3.1 11.3 0l66.3-66.3 63.6 7.1c23.9 2.6 47.9-5.4 65.4-23l181.9-181.9-135.7-135.7-64.9 65zm308.2-93.3L430.5 2.3c-3.1-3.1-8.2-3.1-11.3 0l-11.3 11.3c-3.1 3.1-3.1 8.2 0 11.3l28.3 28.3-45.3 45.3-56.6-56.6-17-17c-3.1-3.1-8.2-3.1-11.3 0l-33.9 33.9c-3.1 3.1-3.1 8.2 0 11.3l17 17L424.8 223l17 17c3.1 3.1 8.2 3.1 11.3 0l33.9-34c3.1-3.1 3.1-8.2 0-11.3l-73.5-73.5 45.3-45.3 28.3 28.3c3.1 3.1 8.2 3.1 11.3 0l11.3-11.3c3.1-3.2 3.1-8.2 0-11.4z"/></svg> Si les `\(X_i\)` sont des variables de Bernoulli indépendantes et si `\(Z=\sum_{i=1}^n X_i\)` alors l'inégalité de Chebychev implique `$$\mathbf{P} \left\{ |Z- \mathbf{E} Z| \geq \sqrt{\frac{n}{4\alpha}} \right\} \leq \alpha$$` -- On en déduit un intervalle de niveau de confiance `\(1-\alpha\)`: `$$\left[\widehat{\theta} - \sqrt{\frac{1}{4n\alpha}}, \widehat{\theta} + \sqrt{\frac{1}{4n\alpha}} \right]$$` -- Pour `\(\alpha=5\%\)`, `\(n=1000\)`, la largeur de l'intervalle est 0.14 Sur nos 10^{4} estimations visualisés sur l'histogramme, 0 intervalles de confiance ne couvrent pas le paramètre à estimer! --- Si on cherche à évaluer le taux de couverture de l'IC déduit de l'inégalité de Bienaymée-Chebychev lorsque la taille de l'échantillon n'est que `\(N=1000\)`, en visant un niveau de confiance `\(1-\alpha\)` avec `\(\alpha=.25\)`, on constate que ce taux évalué à partir de `\(1000\)` essais est largement supérieur au taux de couverture ciblé. Cet intervalle manque définitivement de _précision_: c'est une construction de type _ceinture et bretelles_ <iframe width="560" height="315" src="https://www.youtube.com/embed/VuWzeoIr7J4" frameborder="0" allow="accelerometer; autoplay; clipboard-write; encrypted-media; gyroscope; picture-in-picture" allowfullscreen></iframe> --- On cherche ici à évaluer le taux de couverture de l'IC déduit de l'inégalité de Chebychev lorsque la taille de l'échantillon n'est que `\(N=\)` 1000, en visant un niveau de confiance `\(1-\alpha\)` avec `\(\alpha=.25\)`. <svg aria-hidden="true" role="img" viewBox="0 0 512 512" style="height:1em;width:1em;vertical-align:-0.125em;margin-left:auto;margin-right:auto;font-size:inherit;fill:currentColor;overflow:visible;position:relative;"><path d="M416 48c0-8.84-7.16-16-16-16h-64c-8.84 0-16 7.16-16 16v48h96V48zM63.91 159.99C61.4 253.84 3.46 274.22 0 404v44c0 17.67 14.33 32 32 32h96c17.67 0 32-14.33 32-32V288h32V128H95.84c-17.63 0-31.45 14.37-31.93 31.99zm384.18 0c-.48-17.62-14.3-31.99-31.93-31.99H320v160h32v160c0 17.67 14.33 32 32 32h96c17.67 0 32-14.33 32-32v-44c-3.46-129.78-61.4-150.16-63.91-244.01zM176 32h-64c-8.84 0-16 7.16-16 16v48h96V48c0-8.84-7.16-16-16-16zm48 256h64V128h-64v160z"/></svg> ce taux évalué à partir de `\(1000\)` essais est largement supérieur au taux de couverture ciblé ```r N <- 1000 ; B <- 10000 ; p <- .4 ; alpha <- .25 estimes <- rbinom(n = B, prob = p, size = N)/N couv <- sum(abs(estimes - p) < 1/sqrt(4*alpha*N))/B cat("Taux de couverture empirique de l'IC Chebychev à 75% : ", round(couv* 100, 1), '%') ``` ``` ## Taux de couverture empirique de l'IC Chebychev à 75% : 95.9 % ``` --- ### Definition: intervalle de niveau de confiance _asymptotique_ `\(1-\alpha\)` Lorsque l'espace des paramètres `\(\Theta\)` est inclus dans `\(\mathbb{R}\)`, une suite d' _intervalles de confiance_ `\([\underline{\theta}_n, \overline{\theta}_n]\)` est de niveau de confiance asymptotique `\(1- \alpha\)`_ avec `\(\alpha \in ]0,1[\)` si et seulement si `$$\forall \theta \in \Theta, \qquad \lim_n P_ \theta^{\otimes n} \left\{ \theta \in [\underline{\theta}_n, \overline{\theta}_n]\right\} = 1- \alpha$$` --- ### Construction asymptotique Ici nous ne considérons que des probabilités sur `\(\mathbb{R}\)` <svg aria-hidden="true" role="img" viewBox="0 0 512 512" style="height:1em;width:1em;vertical-align:-0.125em;margin-left:auto;margin-right:auto;font-size:inherit;fill:currentColor;overflow:visible;position:relative;"><path d="M201.5 174.8l55.7 55.8c3.1 3.1 3.1 8.2 0 11.3l-11.3 11.3c-3.1 3.1-8.2 3.1-11.3 0l-55.7-55.8-45.3 45.3 55.8 55.8c3.1 3.1 3.1 8.2 0 11.3l-11.3 11.3c-3.1 3.1-8.2 3.1-11.3 0L111 265.2l-26.4 26.4c-17.3 17.3-25.6 41.1-23 65.4l7.1 63.6L2.3 487c-3.1 3.1-3.1 8.2 0 11.3l11.3 11.3c3.1 3.1 8.2 3.1 11.3 0l66.3-66.3 63.6 7.1c23.9 2.6 47.9-5.4 65.4-23l181.9-181.9-135.7-135.7-64.9 65zm308.2-93.3L430.5 2.3c-3.1-3.1-8.2-3.1-11.3 0l-11.3 11.3c-3.1 3.1-3.1 8.2 0 11.3l28.3 28.3-45.3 45.3-56.6-56.6-17-17c-3.1-3.1-8.2-3.1-11.3 0l-33.9 33.9c-3.1 3.1-3.1 8.2 0 11.3l17 17L424.8 223l17 17c3.1 3.1 8.2 3.1 11.3 0l33.9-34c3.1-3.1 3.1-8.2 0-11.3l-73.5-73.5 45.3-45.3 28.3 28.3c3.1 3.1 8.2 3.1 11.3 0l11.3-11.3c3.1-3.2 3.1-8.2 0-11.4z"/></svg> Les lois sur `\(\mathbb{R}\)` sont complètement caractérisées par leur _fonction de répartition_ Les livres d'introduction aux probabilités contiennent souvent la définition suivante --- ### Definition Convergence faible/étroite <svg aria-hidden="true" role="img" viewBox="0 0 512 512" style="height:1em;width:1em;vertical-align:-0.125em;margin-left:auto;margin-right:auto;font-size:inherit;fill:currentColor;overflow:visible;position:relative;"><path d="M201.5 174.8l55.7 55.8c3.1 3.1 3.1 8.2 0 11.3l-11.3 11.3c-3.1 3.1-8.2 3.1-11.3 0l-55.7-55.8-45.3 45.3 55.8 55.8c3.1 3.1 3.1 8.2 0 11.3l-11.3 11.3c-3.1 3.1-8.2 3.1-11.3 0L111 265.2l-26.4 26.4c-17.3 17.3-25.6 41.1-23 65.4l7.1 63.6L2.3 487c-3.1 3.1-3.1 8.2 0 11.3l11.3 11.3c3.1 3.1 8.2 3.1 11.3 0l66.3-66.3 63.6 7.1c23.9 2.6 47.9-5.4 65.4-23l181.9-181.9-135.7-135.7-64.9 65zm308.2-93.3L430.5 2.3c-3.1-3.1-8.2-3.1-11.3 0l-11.3 11.3c-3.1 3.1-3.1 8.2 0 11.3l28.3 28.3-45.3 45.3-56.6-56.6-17-17c-3.1-3.1-8.2-3.1-11.3 0l-33.9 33.9c-3.1 3.1-3.1 8.2 0 11.3l17 17L424.8 223l17 17c3.1 3.1 8.2 3.1 11.3 0l33.9-34c3.1-3.1 3.1-8.2 0-11.3l-73.5-73.5 45.3-45.3 28.3 28.3c3.1 3.1 8.2 3.1 11.3 0l11.3-11.3c3.1-3.2 3.1-8.2 0-11.4z"/></svg> .bg-light-gray.b--light-gray.ba.bw1.br3.shadow-5.ph4.mt5[ Une suite `\((P_n)_{n\in \mathbb{N}}\)` de probabilités sur `\(\mathbb{R}\)` (de fonctions de répartition `\((F_n)_{n\in \mathbb{N}}\)`) converge _étroitement/faiblement_ vers une loi de probabilité `\(P\)` de fonction de répartition `\(F\)` si et seulement si, pour tout `\(x\)` où `\(F\)` est continue, on a `$$\lim_n F_n(x) = F(x)$$` ] -- <svg aria-hidden="true" role="img" viewBox="0 0 512 512" style="height:1em;width:1em;vertical-align:-0.125em;margin-left:auto;margin-right:auto;font-size:inherit;fill:currentColor;overflow:visible;position:relative;"><path d="M512 199.652c0 23.625-20.65 43.826-44.8 43.826h-99.851c16.34 17.048 18.346 49.766-6.299 70.944 14.288 22.829 2.147 53.017-16.45 62.315C353.574 425.878 322.654 448 272 448c-2.746 0-13.276-.203-16-.195-61.971.168-76.894-31.065-123.731-38.315C120.596 407.683 112 397.599 112 385.786V214.261l.002-.001c.011-18.366 10.607-35.889 28.464-43.845 28.886-12.994 95.413-49.038 107.534-77.323 7.797-18.194 21.384-29.084 40-29.092 34.222-.014 57.752 35.098 44.119 66.908-3.583 8.359-8.312 16.67-14.153 24.918H467.2c23.45 0 44.8 20.543 44.8 43.826zM96 200v192c0 13.255-10.745 24-24 24H24c-13.255 0-24-10.745-24-24V200c0-13.255 10.745-24 24-24h48c13.255 0 24 10.745 24 24zM68 368c0-11.046-8.954-20-20-20s-20 8.954-20 20 8.954 20 20 20 20-8.954 20-20z"/></svg> on utilise la notation `\(\rightsquigarrow\)` pour désigner la convergence en loi/distribution --- La situation des points où `\(F\)` est discontinue est la suivante. ### Proposition .bg-light-gray.b--light-gray.ba.bw1.br3.shadow-5.ph4.mt5[ Si une suite de fonctions de répartition `\((F_n)_{n\in \mathbb{ N}}\)` converge simplement vers une fonction de répartition `\(F\)` en tout point de continuité de `\(F,\)` alors en tout `\(x\)` de `\(\mathbb{R}\)` `$$\limsup_n F_n(x) \leq F(x)$$` ] --- ### Convention : Pour `\(\alpha \in ]0,1[\)`, on note `\(z_{\alpha}\)` le quantile d'ordre `\(1-\alpha\)` de la gaussienne centrée réduite (standard) `\(\mathcal{N}(0,1)\)` C'est la solution de l'équation en `\(x\)`: `$$1-\alpha = \int_{-\infty}^x \frac{\mathrm{e}^{-u^2/2}}{\sqrt{2\pi}} \mathrm{d}u =: \Phi(x)$$` --- ### Théorème Central Limite (De Moivre-Laplace) .bg-light-gray.b--light-gray.ba.bw1.br3.shadow-5.ph4.mt5[ Si les estimateurs `\(\widehat{\theta}_n\)` sont distribués selon `\(P_\theta^{\otimes n}\)`, `$$\frac{\sqrt{n}}{\sqrt{\theta(1-\theta)}} \left( \widehat{\theta}_n -\theta\right) \rightsquigarrow \mathcal{N}(0,1)$$` ] -- Cela se traduit (entre autres) par la convergence simple des fonctions de répartitions: `$$\forall \alpha \in ]0,1[, \qquad \lim_n \mathbf{P}_{\theta}^{\otimes n} \left\{ \frac{\sqrt{n}}{\sqrt{\theta(1-\theta)}} \left( \widehat{\theta}_n -\theta\right) \leq z_{\alpha}\right\} = 1-\alpha$$` --- Si on dispose de deux suites `\((X_n)_{n \in \mathbb{N}}\)` et `\((Y_n)_{n \in \mathbb{N}}\)` de variables aléatoires telles que `$$X_n \rightsquigarrow X \text{ et } Y_n \rightsquigarrow Y$$` -- - on ne peut rien dire _en général_ sur la suite `\((X_n Y_n)_n\)`, - on ne peut pas affirmer _à coup sûr_ que `\(X_n Y_n \rightsquigarrow XY\)` <svg aria-hidden="true" role="img" viewBox="0 0 496 512" style="height:1em;width:0.97em;vertical-align:-0.125em;margin-left:auto;margin-right:auto;font-size:inherit;fill:currentColor;overflow:visible;position:relative;"><path d="M248 8C111 8 0 119 0 256s111 248 248 248 248-111 248-248S385 8 248 8zm80 168c17.7 0 32 14.3 32 32s-14.3 32-32 32-32-14.3-32-32 14.3-32 32-32zm-160 0c17.7 0 32 14.3 32 32s-14.3 32-32 32-32-14.3-32-32 14.3-32 32-32zm170.2 218.2C315.8 367.4 282.9 352 248 352s-67.8 15.4-90.2 42.2c-13.5 16.3-38.1-4.2-24.6-20.5C161.7 339.6 203.6 320 248 320s86.3 19.6 114.7 53.8c13.6 16.2-11 36.7-24.5 20.4z"/></svg> -- Mais, si `\(Y\)` est une variable aléatoire _dégénéree_, presque sûrement égale à une constante `\(y\)`, alors on peut s'appuyer sur le lemme de Slutsky <svg aria-hidden="true" role="img" viewBox="0 0 640 512" style="height:1em;width:1.25em;vertical-align:-0.125em;margin-left:auto;margin-right:auto;font-size:inherit;fill:currentColor;overflow:visible;position:relative;"><path d="M639.4 433.6c-8.4-20.4-31.8-30.1-52.2-21.6l-22.1 9.2-38.7-101.9c47.9-35 64.8-100.3 34.5-152.8L474.3 16c-8-13.9-25.1-19.7-40-13.6L320 49.8 205.7 2.4c-14.9-6.2-32-.3-40 13.6L79.1 166.5C48.9 219 65.7 284.3 113.6 319.2L74.9 421.1l-22.1-9.2c-20.4-8.5-43.7 1.2-52.2 21.6-1.7 4.1.2 8.8 4.3 10.5l162.3 67.4c4.1 1.7 8.7-.2 10.4-4.3 8.4-20.4-1.2-43.8-21.6-52.3l-22.1-9.2L173.3 342c4.4.5 8.8 1.3 13.1 1.3 51.7 0 99.4-33.1 113.4-85.3l20.2-75.4 20.2 75.4c14 52.2 61.7 85.3 113.4 85.3 4.3 0 8.7-.8 13.1-1.3L506 445.6l-22.1 9.2c-20.4 8.5-30.1 31.9-21.6 52.3 1.7 4.1 6.4 6 10.4 4.3L635.1 444c4-1.7 6-6.3 4.3-10.4zM275.9 162.1l-112.1-46.5 36.5-63.4 94.5 39.2-18.9 70.7zm88.2 0l-18.9-70.7 94.5-39.2 36.5 63.4-112.1 46.5z"/></svg> --- ### Lemme de Slutsky .bg-light-gray.b--light-gray.ba.bw1.br3.shadow-5.ph4.mt5[ Si `\((X_n)_n\)` et `\((Y_n)_n\)` sont deux suites de variables aléatoires sur `\((\Omega_n, \mathcal{F}_n, P_n)\)` telles que - `\(X_n \rightsquigarrow X\)` - `\(Y_n \rightsquigarrow y\)` où `\(y\)` est une constante alors `$$(Y_n, X_n) \rightsquigarrow (y,X)$$` ] <svg aria-hidden="true" role="img" viewBox="0 0 512 512" style="height:1em;width:1em;vertical-align:-0.125em;margin-left:auto;margin-right:auto;font-size:inherit;fill:currentColor;overflow:visible;position:relative;"><path d="M512 199.652c0 23.625-20.65 43.826-44.8 43.826h-99.851c16.34 17.048 18.346 49.766-6.299 70.944 14.288 22.829 2.147 53.017-16.45 62.315C353.574 425.878 322.654 448 272 448c-2.746 0-13.276-.203-16-.195-61.971.168-76.894-31.065-123.731-38.315C120.596 407.683 112 397.599 112 385.786V214.261l.002-.001c.011-18.366 10.607-35.889 28.464-43.845 28.886-12.994 95.413-49.038 107.534-77.323 7.797-18.194 21.384-29.084 40-29.092 34.222-.014 57.752 35.098 44.119 66.908-3.583 8.359-8.312 16.67-14.153 24.918H467.2c23.45 0 44.8 20.543 44.8 43.826zM96 200v192c0 13.255-10.745 24-24 24H24c-13.255 0-24-10.745-24-24V200c0-13.255 10.745-24 24-24h48c13.255 0 24 10.745 24 24zM68 368c0-11.046-8.954-20-20-20s-20 8.954-20 20 8.954 20 20 20 20-8.954 20-20z"/></svg> `\(Y_n \rightsquigarrow y\)` implique `\(Y_n \stackrel{\text{en probabilité}}{\longrightarrow} y\)` --- On invoque en général la forme prête à l'emploi ### Théorème .bg-light-gray.b--light-gray.ba.bw1.br3.shadow-5.ph4.mt5[ Si `\((X_n)_n\)` et `\((Y_n)_n\)` est deux suites de variables aléatoires sur `\((\Omega_n, \mathcal{F}_n, P_n)\)` telles que - `\(X_n \rightsquigarrow X\)` à valeurs dans `\(\mathbb{R}^k\)` - `\(Y_n \rightsquigarrow y\)` où `\(y \in \mathbb{R}^{k'}\)` est une constante si `\(g\)` est une fonction continue de `\(\mathbb{R}^k \times \mathbb{R}^{k'}\)` dans `\(\mathbb{R}^{k''}\)` alors `$$g (X_n, Y_n) \rightsquigarrow g (X, y)$$` ] --- ### Preuve Dans la seconde formulation, il suffit (d'après le théorème portemanteau) de s'intéresser au cas des fonctions bornées et lipschitziennes. On suppose `\(\| g \|_\infty \leq b\)` et `\(g\)` `\(L\)`-lipschitzienne `$$\begin{array}{rl}\left| \mathbb{E}\left[ g(X_n, Y_n)\right] - \mathbb{E}\left[g(X,Y)\right] \right| & \leq \left| \mathbb{E}\left[ g(X_n, Y_n)\right] - \mathbb{E}\left[g(X_n,y)\right] \right| \\ & \phantom{\leq} + \left| \mathbb{E}\left[ g(X_n, y)\right] - \mathbb{E}\left[g(X,y)\right] \right|\end{array}$$` `\((X_n) \rightsquigarrow X\)` garantit que `$$\lim_n \left| \mathbb{E}\left[ g(X_n, y)\right] - \mathbb{E}\left[g(X,y)\right] \right| = 0$$` Les hypothèses sur `\(g\)` garantissent `$$\left| g(X_n, Y_n)- g(X_n,y) \right| \leq 2 \mathbb{I}_{d(Y_n,y)> \epsilon} \|g \|_\infty + L \epsilon\qquad ∀ ϵ>0$$` `\((Y_n)_n \rightsquigarrow y\)` implique la convergence en probabilité, donc `$$\lim_n \mathbb{E} \mathbb{I}_{d(Y_n,y)>\epsilon}=0$$` <svg aria-hidden="true" role="img" viewBox="0 0 448 512" style="height:1em;width:0.88em;vertical-align:-0.125em;margin-left:auto;margin-right:auto;font-size:inherit;fill:currentColor;overflow:visible;position:relative;"><path d="M400 32H48C21.5 32 0 53.5 0 80v352c0 26.5 21.5 48 48 48h352c26.5 0 48-21.5 48-48V80c0-26.5-21.5-48-48-48z"/></svg> --- Le lemme de Slutsky, et le fait que `\(\widehat{\theta}_n/\theta\)` converge en probabilité vers `\(1\)` lorsque `\(n\to \infty\)`, permet d'écrire pour tout `\(\alpha \in ]0,1[\)`, `$$\lim_n \mathbf{P}_{\theta}^{\otimes n} \left\{ \frac{\sqrt{n}}{\sqrt{\widehat{\theta}_n(1-\widehat{\theta}_n)}} \left( \widehat{\theta}_n - \theta\right) \leq z_{\alpha}\right\} = 1-\alpha$$` -- Cela conduit à proposer l'intervalle de niveau de confiance asymptotique `\(1-\alpha\)`: `$$\left[\widehat{\theta}_n - z_{\alpha/2}\sqrt{\frac{\widehat{\theta}_n(1-\widehat{\theta}_n)}{n}}, \widehat{\theta}_n + z_{\alpha/2}\sqrt{\frac{\widehat{\theta}_n(1-\widehat{\theta}_n)}{n}}\right]$$` --- ### Visualisation de l'IC asymptotique --- Un raffinement du théorème central limite, le théorème de Berry-Esseen , nous indique que le niveau de confiance est `\(1- \alpha+ O(1/\sqrt{n})\)`. --- template: inter-slide ## Intervalle non-asymptotique construit à partir de l'inégalité de Hoeffding --- L'inégalité de Hoeffding (1963) est la plus simple des _inégalités exponentielles_ qui fournissent des bornes non-asymptotiques sur les probabilités de queue des sommes de variables aléatoires indépendantes ### Lemma de hoeffding .bg-light-gray.b--light-gray.ba.bw1.br3.shadow-5.ph4.mt5[ Si `\(X\)` est une variable aléatoire qui prend ses valeurs dans `\([a,b]\)`, alors `$$\forall \lambda \in \mathbb{R}\qquad \log \mathbb{E} \mathrm{e}^{\lambda (X- \mathbb{E}X)} \leq \frac{\lambda^2 (b-a)^2}{8}$$` ] -- <svg aria-hidden="true" role="img" viewBox="0 0 512 512" style="height:1em;width:1em;vertical-align:-0.125em;margin-left:auto;margin-right:auto;font-size:inherit;fill:currentColor;overflow:visible;position:relative;"><path d="M512 199.652c0 23.625-20.65 43.826-44.8 43.826h-99.851c16.34 17.048 18.346 49.766-6.299 70.944 14.288 22.829 2.147 53.017-16.45 62.315C353.574 425.878 322.654 448 272 448c-2.746 0-13.276-.203-16-.195-61.971.168-76.894-31.065-123.731-38.315C120.596 407.683 112 397.599 112 385.786V214.261l.002-.001c.011-18.366 10.607-35.889 28.464-43.845 28.886-12.994 95.413-49.038 107.534-77.323 7.797-18.194 21.384-29.084 40-29.092 34.222-.014 57.752 35.098 44.119 66.908-3.583 8.359-8.312 16.67-14.153 24.918H467.2c23.45 0 44.8 20.543 44.8 43.826zM96 200v192c0 13.255-10.745 24-24 24H24c-13.255 0-24-10.745-24-24V200c0-13.255 10.745-24 24-24h48c13.255 0 24 10.745 24 24zM68 368c0-11.046-8.954-20-20-20s-20 8.954-20 20 8.954 20 20 20 20-8.954 20-20z"/></svg> `\(\operatorname{var}(X) \leq \frac{(b-a)^2}{4}\)` --- ### Preuve Sans perdre en généralité, on suppose `\(X\)` centrée: au pire cela revient à translater l'intervalle `\([a, b]\)`, ce qui ne change pas sa longueur On note `\(Q\)` la loi (implicite) de la variable aléatoire `\(X\)` <svg aria-hidden="true" role="img" viewBox="0 0 512 512" style="height:1em;width:1em;vertical-align:-0.125em;margin-left:auto;margin-right:auto;font-size:inherit;fill:currentColor;overflow:visible;position:relative;"><path d="M512 199.652c0 23.625-20.65 43.826-44.8 43.826h-99.851c16.34 17.048 18.346 49.766-6.299 70.944 14.288 22.829 2.147 53.017-16.45 62.315C353.574 425.878 322.654 448 272 448c-2.746 0-13.276-.203-16-.195-61.971.168-76.894-31.065-123.731-38.315C120.596 407.683 112 397.599 112 385.786V214.261l.002-.001c.011-18.366 10.607-35.889 28.464-43.845 28.886-12.994 95.413-49.038 107.534-77.323 7.797-18.194 21.384-29.084 40-29.092 34.222-.014 57.752 35.098 44.119 66.908-3.583 8.359-8.312 16.67-14.153 24.918H467.2c23.45 0 44.8 20.543 44.8 43.826zM96 200v192c0 13.255-10.745 24-24 24H24c-13.255 0-24-10.745-24-24V200c0-13.255 10.745-24 24-24h48c13.255 0 24 10.745 24 24zM68 368c0-11.046-8.954-20-20-20s-20 8.954-20 20 8.954 20 20 20 20-8.954 20-20z"/></svg> la variance de toute variable aléatoire qui prend ses valeurs dans `\([a,b]\)` est majorée par `\((b-a)^2/4\)` <svg aria-hidden="true" role="img" viewBox="0 0 576 512" style="height:1em;width:1.12em;vertical-align:-0.125em;margin-left:auto;margin-right:auto;font-size:inherit;fill:currentColor;overflow:visible;position:relative;"><path d="M208 0c-29.9 0-54.7 20.5-61.8 48.2-.8 0-1.4-.2-2.2-.2-35.3 0-64 28.7-64 64 0 4.8.6 9.5 1.7 14C52.5 138 32 166.6 32 200c0 12.6 3.2 24.3 8.3 34.9C16.3 248.7 0 274.3 0 304c0 33.3 20.4 61.9 49.4 73.9-.9 4.6-1.4 9.3-1.4 14.1 0 39.8 32.2 72 72 72 4.1 0 8.1-.5 12-1.2 9.6 28.5 36.2 49.2 68 49.2 39.8 0 72-32.2 72-72V64c0-35.3-28.7-64-64-64zm368 304c0-29.7-16.3-55.3-40.3-69.1 5.2-10.6 8.3-22.3 8.3-34.9 0-33.4-20.5-62-49.7-74 1-4.5 1.7-9.2 1.7-14 0-35.3-28.7-64-64-64-.8 0-1.5.2-2.2.2C422.7 20.5 397.9 0 368 0c-35.3 0-64 28.6-64 64v376c0 39.8 32.2 72 72 72 31.8 0 58.4-20.7 68-49.2 3.9.7 7.9 1.2 12 1.2 39.8 0 72-32.2 72-72 0-4.8-.5-9.5-1.4-14.1 29-12 49.4-40.6 49.4-73.9z"/></svg> vérifiez ! Considérons maintenant la fonction `\(F\)` de `\(\lambda\)` définie par `$$F(\lambda) = \log \mathbb{E}_Q \mathrm{e}^{\lambda X}$$` Notons `\(Q_\lambda\)` la loi de densité `\(\exp\left(\lambda x - F(\lambda)\right)\)` par rapport à `\(Q\)` <svg aria-hidden="true" role="img" viewBox="0 0 576 512" style="height:1em;width:1.12em;vertical-align:-0.125em;margin-left:auto;margin-right:auto;font-size:inherit;fill:currentColor;overflow:visible;position:relative;"><path d="M208 0c-29.9 0-54.7 20.5-61.8 48.2-.8 0-1.4-.2-2.2-.2-35.3 0-64 28.7-64 64 0 4.8.6 9.5 1.7 14C52.5 138 32 166.6 32 200c0 12.6 3.2 24.3 8.3 34.9C16.3 248.7 0 274.3 0 304c0 33.3 20.4 61.9 49.4 73.9-.9 4.6-1.4 9.3-1.4 14.1 0 39.8 32.2 72 72 72 4.1 0 8.1-.5 12-1.2 9.6 28.5 36.2 49.2 68 49.2 39.8 0 72-32.2 72-72V64c0-35.3-28.7-64-64-64zm368 304c0-29.7-16.3-55.3-40.3-69.1 5.2-10.6 8.3-22.3 8.3-34.9 0-33.4-20.5-62-49.7-74 1-4.5 1.7-9.2 1.7-14 0-35.3-28.7-64-64-64-.8 0-1.5.2-2.2.2C422.7 20.5 397.9 0 368 0c-35.3 0-64 28.6-64 64v376c0 39.8 32.2 72 72 72 31.8 0 58.4-20.7 68-49.2 3.9.7 7.9 1.2 12 1.2 39.8 0 72-32.2 72-72 0-4.8-.5-9.5-1.4-14.1 29-12 49.4-40.6 49.4-73.9z"/></svg> vérifiez `$$F'(\lambda) = \mathbb{E}_{Q_ \lambda} X \qquad \text{ et } \qquad F^{\prime\prime}(\lambda) = \operatorname{var}_{Q_ \lambda} (X)$$` --- ### Preuve (suite) Comme `\(Q_ \lambda\)` est absolument continue par rapport à `\(Q\)`, sous `\(Q_ \lambda\)`, `\(X\)` est à valeur dans `\([a,b]\)` et donc `$$F^{\prime\prime}(\lambda) = \operatorname{var}_{Q_ \lambda} (X) \leq \frac{(b-a)^2}{4}$$` On peut intégrer cette inégalité différentielle en notant au passage que `\(F(0)=F'(0)=0\)`, et vérifier `$$F(\lambda) \leq \frac{\lambda^2 (b-a)^2}{8}$$` <svg aria-hidden="true" role="img" viewBox="0 0 448 512" style="height:1em;width:0.88em;vertical-align:-0.125em;margin-left:auto;margin-right:auto;font-size:inherit;fill:currentColor;overflow:visible;position:relative;"><path d="M400 32H48C21.5 32 0 53.5 0 80v352c0 26.5 21.5 48 48 48h352c26.5 0 48-21.5 48-48V80c0-26.5-21.5-48-48-48z"/></svg> --- ### Inégalité de hoeffding .bg-light-gray.b--light-gray.ba.bw1.br3.shadow-5.ph4.mt5[ Si les `\((X_i)_{i \leq n}\)` sont des variables aléatoires _indépendantes_ à valeur dans `\([a_i, b_i]\)` et si `\(Z=\sum_{i=1}^n X_i\)` alors `$$\forall t >0, \qquad \mathbb{P} \left\{ Z \geq \mathbb{E}Z + t \right\} \leq \mathrm{e}^{- \frac{2 t^2}{\sum_{i=1}^n (b_i-a_i)^2}}$$` ] --- ### Preuve La preuve se réduit à une invocation de l'inégalité de Markov exponentielle `$$\mathbb{P} \left\{ Z \geq \mathbb{E}Z + t \right\} \leq \inf_{\lambda\geq 0} \frac{\mathbb{E} \mathrm{e}^{\lambda (Z-\mathbb{E}Z)}}{\mathrm{e}^{\lambda t}}$$` et du lemme de Hoeffding `$$\begin{array}{rl}\mathbb{E} \mathrm{e}^{\lambda (Z - \mathbb{E}Z)} & = \mathbb{E} \mathrm{e}^{\lambda \sum_i (X_i - \mathbb{E}X_i) }\\ & = \prod_{i=1}^n \mathbb{E} \mathrm{e}^{\lambda (X_i - \mathbb{E}X_i) }\\ & \leq \prod_{i=1}^n \mathrm{e}^{\frac{\lambda^2 (b_i-a_i)^2}{8}}\end{array}$$` <svg aria-hidden="true" role="img" viewBox="0 0 448 512" style="height:1em;width:0.88em;vertical-align:-0.125em;margin-left:auto;margin-right:auto;font-size:inherit;fill:currentColor;overflow:visible;position:relative;"><path d="M400 32H48C21.5 32 0 53.5 0 80v352c0 26.5 21.5 48 48 48h352c26.5 0 48-21.5 48-48V80c0-26.5-21.5-48-48-48z"/></svg> --- ### Intervalle de confiance fondé sur l'inégalité de Hoeffding Si les `\(X_i\)` sont des variables de Bernoulli indépendantes et si `\(Z=\sum_{i=1}^n X_i\)` alors l'inégalité de Hoeffding implique `$$\mathbf{P} \left\{ |Z- \mathbf{E} Z| \geq \sqrt{\frac{n\log (2/\alpha)}{2}} \right\} \leq \alpha$$` On en déduit un intervalle de niveau de confiance `\(1-\alpha\)`: `$$\left[\widehat{\theta} - \sqrt{\frac{\log (2/\alpha)}{2n}}, \widehat{\theta} + \sqrt{\frac{\log (2/\alpha)}{2n}} \right]$$` Dans toutes les constructions on retrouve deux ingrédients, l'intervalle est d'une largeur proportionnelle à - `\(\sqrt{{1}/{n}}\)` et - un facteur qui dépend du niveau de couverture recherché Meilleurs sont nos renseignements sur les fluctuations de `\(\overline{X}_n\)` autour de son espérance, plus précis est l'intervalle de confiance --- ### Comparaison des taux de couverture On cherche ici à comparer le taux de couverture des IC déduits de - inégalité de Chebychev - inégalité de Hoeffding - de la constriction asymptotique Lorsque la taille de l'échantillon est `\(N=\)` 10^{4}, en visant un niveau de confiance `\(1-\alpha\)` avec `\(\alpha=\)` 0.05. Le paramètre `\(\theta\)` utilisé est 0.4. <svg aria-hidden="true" role="img" viewBox="0 0 512 512" style="height:1em;width:1em;vertical-align:-0.125em;margin-left:auto;margin-right:auto;font-size:inherit;fill:currentColor;overflow:visible;position:relative;"><path d="M416 48c0-8.84-7.16-16-16-16h-64c-8.84 0-16 7.16-16 16v48h96V48zM63.91 159.99C61.4 253.84 3.46 274.22 0 404v44c0 17.67 14.33 32 32 32h96c17.67 0 32-14.33 32-32V288h32V128H95.84c-17.63 0-31.45 14.37-31.93 31.99zm384.18 0c-.48-17.62-14.3-31.99-31.93-31.99H320v160h32v160c0 17.67 14.33 32 32 32h96c17.67 0 32-14.33 32-32v-44c-3.46-129.78-61.4-150.16-63.91-244.01zM176 32h-64c-8.84 0-16 7.16-16 16v48h96V48c0-8.84-7.16-16-16-16zm48 256h64V128h-64v160z"/></svg> Le taux de couverture est évalué à partir de `\(B=\)` 1000 essais ``` ## Taux de couverture empirique de l'IC Chebychev à 5% : 100 % largeur : 0.0447 ``` ``` ## Taux de couverture empirique de l'IC Hoeffding à 5% : 98 % largeur : 0.0215 ``` ``` ## Taux de couverture empirique de l'IC Asymptotique à 5% : 96.6 % largeur moyenne : 0.0192 ``` --- exclude: true ### Construction calculatoire Dans cette section, on note `\(\operatorname{qb}(\alpha,n,\theta)\)` le quantile d'ordre `\(\alpha\)` de la loi binomiale de paramètres `\(n,\theta\)` (cela correspond à la fonction \texttt{qbinom()} de \texttt{R}). On définit la région empirique `$$\left\{\theta': \operatorname{qb}(\alpha/2,n,\theta') \leq n\widehat{\theta}_n \leq \operatorname{qb}(1-\alpha/2,n,\theta')\right\}$$` Cette région est un intervalle. On peut le vérifier à l'aide d'un argument de _domination stochastique}: si `\(0<\theta < \theta'<1\)` et si `\(F_{n,\theta}\)`, `\(F_{n,\theta'}\)` désignent les fonctions de répartition des binomiales de paramètres `\((n,\theta)\)` et `\((n,\theta')\)`, alors pour tout `\(x\)` `$$F_{n,\theta'}(x) \leq F_{n,\theta}(x)$$` --- exclude: true Cette dernière relation se vérifie par un argument de couplage. La région de confiance est délimitée par `$$\underline{\theta} = \inf \{ \theta': \operatorname{qb}(1-\alpha/2,n,\theta')\geq n\widehat{\theta}_n \}$$` et `$$\overline{\theta} = \sup \{ \theta': \operatorname{qb}(\alpha/2,n,\theta')\leq n\widehat{\theta}_n \}$$` C'est aussi une région de niveau de confiance `\(1-\alpha + O(1/\sqrt{n})\)`. --- template: inter-slide ## Tests --- ### Definition: Hypothèse .bg-light-gray.b--light-gray.ba.bw1.br3.shadow-5.ph4.mt5[ Une _hypothèse_ est une collection de loi de probabilités. La collection peut être réduite à une seule loi, on parle alors d'_hypothèse simple_, Sinon on parle d'_hypothèse composée ou composite_ ] --- Notre problème jouet pose un problème de _test binaire_ 1. `\(H_0\)`: l'_hypothèse nulle_, `\(\theta \leq \theta_0 =.5\)` contre 1. `\(H_1\)`: l'_alternative_ `\(\theta > .5\)`. Une procédure de test binaire est une fonction des données qui vaut - `\(1\)` (on rejette l'hypothèse nulle `\(H_0\)`) ou - `\(0\)` (on ne rejette pas `\(H_0\)`). Dans la suite on notera `\(T\)` le (la procédure de) test binaire. --- <svg aria-hidden="true" role="img" viewBox="0 0 576 512" style="height:1em;width:1.12em;vertical-align:-0.125em;margin-left:auto;margin-right:auto;font-size:inherit;fill:currentColor;overflow:visible;position:relative;"><path d="M208 0c-29.9 0-54.7 20.5-61.8 48.2-.8 0-1.4-.2-2.2-.2-35.3 0-64 28.7-64 64 0 4.8.6 9.5 1.7 14C52.5 138 32 166.6 32 200c0 12.6 3.2 24.3 8.3 34.9C16.3 248.7 0 274.3 0 304c0 33.3 20.4 61.9 49.4 73.9-.9 4.6-1.4 9.3-1.4 14.1 0 39.8 32.2 72 72 72 4.1 0 8.1-.5 12-1.2 9.6 28.5 36.2 49.2 68 49.2 39.8 0 72-32.2 72-72V64c0-35.3-28.7-64-64-64zm368 304c0-29.7-16.3-55.3-40.3-69.1 5.2-10.6 8.3-22.3 8.3-34.9 0-33.4-20.5-62-49.7-74 1-4.5 1.7-9.2 1.7-14 0-35.3-28.7-64-64-64-.8 0-1.5.2-2.2.2C422.7 20.5 397.9 0 368 0c-35.3 0-64 28.6-64 64v376c0 39.8 32.2 72 72 72 31.8 0 58.4-20.7 68-49.2 3.9.7 7.9 1.2 12 1.2 39.8 0 72-32.2 72-72 0-4.8-.5-9.5-1.4-14.1 29-12 49.4-40.6 49.4-73.9z"/></svg> On peut se demander pourquoi on emploie l'expression _on ne rejette pas l'hypothèse nulle `\(H_0\)`_, plutôt que _on accepte l'hypothèse nulle_. Ce n'est pas par goût des formes négatives. C'est parce que dans les usages historiques qui ont conduit à la construction de la notion de test, l'hypothèse nulle et l'alternative ne jouent pas le même rôle. L'hypothèse nulle correspond à une position conservatrice. --- Lorsqu'on procède à des essais cliniques, pour évaluer l'intérêt de mettre sur le marché un nouveau médicament, - l'hypothèse nulle affirme que ce nouveau traitement ne vaut pas mieux que l'existant, - l'alternative affirme qu'au contraire ce nouveau traitement est meilleur -- Ne pas rejeter l'hypothèse nulle, cela ne veut pas dire accepter l'existant pour l'éternité, mais s'y tenir jusqu'à l'apparition d'éléments nouveaux -- On note - `\(\mathcal{P}_0\)` : la collection des lois de probabilité qui définissent l'hypothèse nulle et - `\(\mathcal{P}_1\)` :la collection des lois de probabilité qui définissent l'alternative --- ### Définition: les type d'erreurs De même que le risque quadratique nous permet de quantifier les performances d'un estimateur, les notions d'_erreur de première et de seconde espèce_ nous permettent de quantifier les performances d'un test binaire Notez qu'il nous faut introduire deux quantités pour quantifier les performances d'un test .bg-light-gray.b--light-gray.ba.bw1.br3.shadow-5.ph4.mt5[ - Une _erreur de première espèce_ consiste à rejeter `\(H_0\)` à tort lorsque les données sont des tirages selon une loi appartenant à l'hypothèse nulle (les données sont tirées sous l'hypothèse nulle). - Une _erreur de seconde espèce_ consiste à ne pas rejeter `\(H_0\)` à tort lorsque les données sont des tirages selon une loi appartenant à l'hypothèse alternative (les données sont tirées sous l'alternative). ] --- ### Niveau et puissance .bg-light-gray.b--light-gray.ba.bw1.br3.shadow-5.ph4.mt5[ On appelle _niveau_ du test `\(T\)`, `$$\sup_{P \in \mathcal{P}_0 } P \{ T= 1\}$$` (le supremum de l'erreur de première espèce) On appelle _puissance_ du test `\(T\)` sous `\(P \in \mathcal{P}_1 \cup \mathcal{P}_0\)`, la probabilité que `\(T\)` rejette `\(H_0\)` sous `\(P\)`: `$$\beta_T(P)= P\{ T=1\}$$` ] --- Sous l'alternative, la puissance est le complément à un de l'erreur de seconde espèce. On veut à la fois un test de petit niveau et de grande puissance sous l'alternative Ces deux objectifs sont antagonistes Dans le cas où on teste deux hypothèses simples, il existe une méthodologie qui réalise le meilleur compromis possible --- ### Tests dits de rapport de vraisemblance On peut associer - à chaque `\(\theta \in ]0,1[\)` et - à chaque échantillon `\(x_1, \ldots, x_n\)`, une _vraisemblance_ : la probabilité de `\(x_1, \ldots, x_n\)` sous `\(P_ \theta^{\otimes n}\)`: `$$P_ \theta^{\otimes n} \{ x_1 , \ldots, x_n\} = \left( \frac{\theta}{1- \theta}\right)^{n \overline{X}_n} (1- \theta)^n$$` --- ### Definition Test de rapport de vraisemblance entre hypothèses simples .bg-light-gray.b--light-gray.ba.bw1.br3.shadow-5.ph4.mt5[ Un _test de rapport de vraisemblance_ de `\(H_1\)` contre `\(H_0\)` consiste à comparer le rapport `$$P_{\theta_1}^{\otimes n} \{ x_1 , \ldots, x_n\}/ P_ {\theta_0}^{\otimes n} \{ x_1 , \ldots, x_n\}$$` à un seuil, - à rejeter `\(H_0\)` si le seuil est dépassé, - à ne pas rejeter `\(H_0\)` si le seuil n'est pas dépassé. ] --- Ici, le rapport de vraisemblance est une fonction de `$$\overline{X}_n = \sum_{i=1}^n X_i/n= \widehat{\theta}_n$$` ce n'est pas du tout une simple coïncidence `$$\left(\frac{1-\theta_1}{1-\theta_0}\right)^n \left(\frac{\theta_1(1-\theta_0)}{\theta_0(1-\theta_1)} \right)^{n \widehat{\theta}_n}$$` <svg aria-hidden="true" role="img" viewBox="0 0 512 512" style="height:1em;width:1em;vertical-align:-0.125em;margin-left:auto;margin-right:auto;font-size:inherit;fill:currentColor;overflow:visible;position:relative;"><path d="M512 199.652c0 23.625-20.65 43.826-44.8 43.826h-99.851c16.34 17.048 18.346 49.766-6.299 70.944 14.288 22.829 2.147 53.017-16.45 62.315C353.574 425.878 322.654 448 272 448c-2.746 0-13.276-.203-16-.195-61.971.168-76.894-31.065-123.731-38.315C120.596 407.683 112 397.599 112 385.786V214.261l.002-.001c.011-18.366 10.607-35.889 28.464-43.845 28.886-12.994 95.413-49.038 107.534-77.323 7.797-18.194 21.384-29.084 40-29.092 34.222-.014 57.752 35.098 44.119 66.908-3.583 8.359-8.312 16.67-14.153 24.918H467.2c23.45 0 44.8 20.543 44.8 43.826zM96 200v192c0 13.255-10.745 24-24 24H24c-13.255 0-24-10.745-24-24V200c0-13.255 10.745-24 24-24h48c13.255 0 24 10.745 24 24zM68 368c0-11.046-8.954-20-20-20s-20 8.954-20 20 8.954 20 20 20 20-8.954 20-20z"/></svg> Comparer le rapport de vraisemblance à un seuil est équivalent à comparer `\(\widehat{\theta}_n\)` à un seuil - On rejette `\(H_0\)` lorsque `\(\widehat{\theta}_n\)` dépasse le seuil, - On ne rejette pas `\(H_0\)` si `\(\widehat{\theta}_n\)` ne dépasse pas le seuil --- class: middle, center, inverse ## Optimalité des tests dits de rapport de vraisemblance --- ### Version préliminaire du Lemme de Neyman-Pearson .bg-light-gray.b--light-gray.ba.bw1.br3.shadow-5.ph4.mt5[ S'il existe un test de rapport de vraisemblance `\(T_0\)` de niveau `\(\alpha > 0\)` et de fonction puissance `\(\beta_{T_0}\)`, alors pour tout test `\(T\)` de niveau inférieur ou égal à `\(\alpha\)`, la fonction puissance `\(\beta_T\)` de `\(T\)` vérifie `$$\beta_T (P_1) \leq \beta_{T_0} (P_1)$$` ] -- Pour son niveau, le test de rapport de vraisemblance est de puissance maximale sous l'alternative --- class: middle, center, inverse background-image: url('./img/brutal.jpg') background-size: cover ## Dernière preuve --- ### Preuve On note `\(p_0 ()\)` \ et `\(p_1 ()\)` les versions des densités utilisées dans la définition du test `\(T_0\)` Il existe une valeur `\(\tau < \infty\)`, telle que `$$P_0 \left\{ p_0 (X) / p_1 (X) > \tau \right\} = \alpha$$` Et `\(T_0\)` est défini par `$$T_0 (x) = \mathbb{I}_{p_1 (x) / p_0 (x) > \tau .}$$` --- ### Preuve (suite) La preuve du lemme de Neymann-Pearson se réduit alors à: `$$\begin{array}{rcl}\beta_{T_0} (P_1) - \beta_T (P_1) & = & \mathbb{E}_{P_1} \left[ T_0 - T \right]\\ & = & \mathbb{E}_{P_0} \left[ \frac{p_1 (X)}{p_0 (X)_{}} (T_0 - T) \right] + \mathbb{E}_{P_1} \left[ (T_0 - T) \mathbb{I}_{p_0 (X) = 0} \right]\\ & & \text{sur l'événement } p_0 (X) = 0, T_0 = 1, \operatorname{car} \operatorname{le} \operatorname{rapport}\\ & & \operatorname{de} \operatorname{vraisemblance} \operatorname{est} \operatorname{infini}\\ & \geq & \mathbb{E}_{P_0} \left[ \frac{p_1 (X)}{p_0 (X)_{}} (T_0 - T) \right]\\ & = & \mathbb{E}_{P_0} \left[ \left( \frac{p_1 (X)}{p_0 (X)_{}} - \tau \right) (T_0 - T) \right] + \tau \mathbb{E}_{P_0} \left[ T_0 - T \right]\\ & & \operatorname{comme} \left( \frac{p_1 (X)}{p_0 (X)_{}} - \tau \right) (T_0 - T) \geq 0,\\ & \geq & \tau \mathbb{E}_{P_0} \left[ T_0 - T \right] \\ & \geq & 0\end{array}$$` <svg aria-hidden="true" role="img" viewBox="0 0 448 512" style="height:1em;width:0.88em;vertical-align:-0.125em;margin-left:auto;margin-right:auto;font-size:inherit;fill:currentColor;overflow:visible;position:relative;"><path d="M400 32H48C21.5 32 0 53.5 0 80v352c0 26.5 21.5 48 48 48h352c26.5 0 48-21.5 48-48V80c0-26.5-21.5-48-48-48z"/></svg> --- ### Courbe ROC des tests de rapport de vraisemblance .fl.w-two-thirds.pa2[ <img src="cm-1-stats_files/figure-html/niveaupuissance-1.png" width="504" /> ] .fl.w-third.pa2[ Courbes puissance en fonction du niveau pour des tests de rapports de vraisemblance entre deux Bernoullis de paramètres 0.5 et 0.525, pour différentes tailles d'échantillons `n` Pour chaque courbe puissance/niveau, le meilleur compromis erreur de première espèce/erreur de seconde espèce est la distance `\(\ell_1\)` au point `\((0,1)\)`. Cette distance diminue lorsque la taille de l'échantillon augmente. ] --- class: middle, center, inverse ## Références --- exclude: true Pour une introduction puissante mais d'un formalisme minimal à la modélisation statistique, on pourra lire _Statistical models} de \citet{Fre05} et le volume compagnon \citep{freedman2009statistical}. Il s'agit de livres écrits par un mathématicien engagé, pour un public cultivé mais large. Une discussion critique et érudite de l'usage de l'inférence statistique dans la vie. Les ouvrages de \citet*{LehRom05} \citet*{LehCas98} constituent toujours une somme sur les problèmes fondamentaux de la statistique. L'inégalité de Hoeffding est la plus simple des inégalités de concentration. Voir \cite{Led01} pour une perspective générale sur le phénomène de concentration, \cite{BoLuMa13} pour un exposé tourné vers les applications. --- class: middle, center, inverse background-image: url('./img/pexels-cottonbro-3171837.jpg') background-size: cover # The End